効率的なデータ収集と安定した運用を実現する、最新のWebスクレイピング開発手法を解説します。AI解析機能や自動エラー復旧など、次世代の機能を実装した実践的な開発ガイドをお届けします。

この記事で分かること

- 効率的なWebスクレイピングシステムの設計方法と具体的な実装手順を学べます

- 安定性の高い抽出処理の実装手順とエラーハンドリング手法を理解できます

- AIを活用した高度な解析機能の実装方法と精度向上のテクニックを習得できます

- 24時間365日の安定運用を実現する監視体制の確立方法を把握できます

この記事を読んでほしい人

- データ収集の効率化を目指すエンジニアの方

- スクレイピングシステムの安定性向上を検討している方

- 大規模データ収集の自動化に取り組む開発者の方

- 運用効率の改善を課題としている管理者の方

最新のWebスクレイピング開発トレンド

2025年におけるWebスクレイピング技術は、AI技術と自動化の融合により大きな進化を遂げています。従来の単純なデータ収集から、インテリジェントな分析と自動化を組み合わせた次世代のシステムへと発展を続けています。

本セクションでは、最新のトレンドと実装技術について詳しく解説していきます。特に注目すべきは、AI技術の導入による精度向上、分散処理による処理速度の改善、そして自動化技術による運用効率の向上です。これらの技術革新により、Webスクレイピングの応用範囲は急速に拡大しており、ビジネスにおける重要性も増しています。

AI解析機能による精度向上

人工知能技術の発展により、Webスクレイピングの精度と効率が飛躍的に向上しています。従来の固定的なルールベースの手法から、より柔軟で適応性の高いシステムへと進化を遂げており、多くの企業がこの技術を採用し始めています。

特に深層学習モデルの導入により、複雑なWebページ構造の解析や動的コンテンツの処理が格段に効率化されています。実際の導入企業では、データ収集の精度が平均して85%から98%に向上し、作業工数を60%削減することに成功しています。

パターン認識による構造解析

Webページの構造をAIが自動的に解析し、最適なデータ抽出ポイントを特定することが可能となっています。従来のような手動でのセレクタ設定が不要となり、開発効率が大幅に向上しています。

さらに、ページレイアウトが変更された場合でも、AIが新しい構造を学習して自動的に対応することができます。これにより、メンテナンスコストを50%以上削減することに成功している事例も報告されています。

特に注目すべきは、深層学習モデルによるDOM構造の自動解析機能です。この技術により、HTMLの構造変更を事前に検知し、抽出ルールを自動的に更新することが可能となっています。また、類似ページの構造を学習することで、新規サイトへの対応も効率化されています。

自然言語処理の活用

テキストデータの抽出精度が自然言語処理技術の導入により向上しています。コンテキストを理解し、必要な情報を的確に抽出することが可能となり、データの品質が大幅に改善されています。また、多言語対応も容易になり、グローバルなデータ収集プロジェクトでの活用が進んでいます。

特筆すべきは、BERTやGPT系の言語モデルを活用した高度な文脈理解です。これにより、複雑な条件での情報抽出や、文脈に応じたデータの分類が可能となっています。実際の導入事例では、テキストデータの抽出精度が従来比で25%向上し、多言語対応のコストを40%削減することに成功しています。

画像認識技術の統合

最新のスクレイピングシステムでは、画像認識技術との統合が進んでいます。商品画像からの情報抽出や、画像内のテキスト認識により、データ収集の範囲が大きく広がっています。

特に、ECサイトでの商品情報収集において、画像からの属性抽出が可能となり、データの網羅性が向上しています。

具体的には、商品画像から色、形状、ブランドロゴなどを自動認識し、テキストデータと組み合わせることで、より豊富な商品情報を収集できるようになっています。この技術により、データ収集の範囲が従来比で2倍に拡大し、人手による確認作業を80%削減することが可能となっています。

分散処理による高速化

大規模データ収集の需要増加に伴い、処理の高速化と効率化が重要なトレンドとなっています。最新の分散処理技術を活用することで、従来比で処理速度を大幅に向上させることが可能となっています。

特に注目すべきは、クラウドネイティブな構成による柔軟なリソース管理と、グローバルな分散処理の実現です。実際の大規模システムでは、1日あたり1,000万ページ以上の処理を安定して実行できる性能を達成しています。

マイクロサービス化の進展

スクレイピングシステムをマイクロサービスとして実装することで、柔軟なスケーリングと効率的なリソース管理を実現しています。各コンポーネントを独立して最適化できるため、システム全体の性能向上が容易となっています。

実際の導入事例では、処理速度の70%向上と運用コストの40%削減を達成しています。特に重要なのは、サービスごとの独立したスケーリングが可能となることです。これにより、急激な負荷変動にも効率的に対応できるようになっています。また、障害の影響範囲も局所化され、システム全体の安定性が向上しています。

エッジコンピューティングの活用

データ収集ポイントを地理的に分散配置することで、効率的なリソース利用とレイテンシの低減を実現しています。特にグローバルな展開を行う企業において、地域ごとの最適化が可能となり、データ収集の効率が大幅に向上しています。

具体的には、世界各地のエッジロケーションを活用することで、平均応答時間を200ms以下に抑えることに成功しています。さらに、地域ごとのアクセス制御やプロキシ管理も容易となり、より安定したデータ収集が可能となっています。また、コンテンツデリバリーネットワーク(CDN)との統合により、帯域幅の効率的な利用も実現しています。

クラウドリソースの最適活用

クラウドプラットフォームの特性を活かした効率的なリソース管理が実現しています。オートスケーリングとスポットインスタンスの組み合わせにより、コストを最適化しつつ、必要な処理能力を確保しています。

具体的には、負荷予測に基づく事前スケーリングや、優先度に応じたリソース配分により、コストを従来比で45%削減することに成功している事例があります。また、マルチクラウド戦略の採用により、可用性の向上とベンダーロックインの回避も実現しています。

自動化技術の進化

運用管理の効率化を実現する自動化技術が急速に発展しています。人手による管理を最小限に抑えつつ、安定したシステム運用を実現する手法が確立されてきています。特に注目すべきは、AIによる自律的な運用管理の実現です。システムが自己診断と最適化を行うことで、運用者の負担を大幅に軽減することが可能となっています。

インテリジェントスケジューリング

機械学習を活用して、最適なクローリングスケジュールを自動的に決定するシステムが実用化されています。サイトごとの更新頻度や負荷状況を分析し、効率的なデータ収集を実現しています。これにより、サーバー負荷を抑えつつ、データの鮮度を維持することが可能となっています。

特に注目すべきは、更新パターンの自動学習機能です。過去のデータ更新履歴を分析することで、サイトごとの最適なクローリング間隔を予測し、効率的なスケジュールを自動生成します。この技術により、不要なアクセスを75%削減しつつ、データの鮮度を95%以上維持することが可能となっています。

自動エラー復旧システム

システムの異常を検知し、適切な対応を自動的に実行する仕組みが一般化しています。エラーパターンの学習により、問題の予測と予防的な対応が可能となり、システムの安定性が大幅に向上しています。導入企業では、ダウンタイムを80%削減できたという報告もあります。

具体的には、ネットワークエラー、認証エラー、構造変更による抽出エラーなど、様々な問題に対して自動的な対応が可能となっています。さらに、AIによる異常検知により、問題が深刻化する前に予防的な対応を取ることができ、システムの稼働率は99.9%以上を維持しています。

データ品質管理の革新

収集データの品質を維持・向上させるための新しい技術が登場しています。AIを活用した品質チェックと、自動補正機能の組み合わせにより、高品質なデータ収集が実現しています。

特に重要なのは、データの正確性と一貫性を自動的に検証する機能です。この技術により、人手による確認作業を最小限に抑えつつ、高い品質基準を維持することが可能となっています。

品質検証の自動化

統計的手法とAIを組み合わせた品質検証システムにより、異常値の検出精度が向上しています。従来は見逃されていた微細な異常も検出可能となり、データの信頼性が大幅に向上しています。

具体的には、時系列分析による異常値検出、データ間の整合性チェック、フォーマット検証など、多角的な品質検証を自動的に実行します。この技術により、データ品質の問題を99%以上の精度で検出することが可能となり、手動での確認作業を90%削減することに成功しています。

リアルタイムデータクレンジング

収集したデータをリアルタイムで正規化し、一貫性のある形式に変換する技術が確立されています。複数ソースからのデータを統合する際の品質維持が容易となり、後続の分析プロセスの効率化にも貢献しています。

特に注目すべきは、機械学習を活用したデータクレンジング機能です。類似データの学習により、表記ゆれの自動補正や、欠損値の予測補完が可能となっています。また、マスターデータとの自動マッチングにより、データの標準化も効率的に行うことができます。これらの技術により、データクレンジングにかかる工数を従来比で65%削減することに成功しています。

セキュリティ対策の強化

データ収集におけるセキュリティ対策も進化を続けています。プライバシー保護と法令遵守を両立させながら、効率的なデータ収集を実現する手法が確立されています。特に重要なのは、収集データの安全な管理と、アクセス制御の最適化です。これらの技術により、セキュアなデータ収集基盤の構築が可能となっています。

プライバシー保護機能の実装

個人情報の取り扱いに関する規制が強化される中、自動的な個人情報の検出と匿名化処理が標準的な機能となっています。収集段階でのプライバシー保護を実現することで、安全なデータ活用が可能となっています。

具体的には、メールアドレス、電話番号、氏名などの個人情報を自動検出し、適切なマスキングや暗号化を行います。この技術により、コンプライアンス違反のリスクを最小化しつつ、必要なデータの収集を継続することができます。さらに、地域ごとの法規制に応じた柔軟な対応も可能となっており、グローバルな展開を行う企業でも安全なデータ収集を実現しています。

アクセス制御の最適化

収集先サイトへの負荷を最小限に抑えるため、インテリジェントなアクセス制御機能が実装されています。サイトごとのアクセスポリシーを学習し、適切なリクエスト間隔とアクセスパターンを自動的に決定します。これにより、対象サイトとの良好な関係を維持しつつ、必要なデータを確実に収集することが可能となっています。

また、複数のプロキシサーバーを活用した分散アクセスにより、特定IPからのアクセス集中を回避する工夫も行われています。これらの技術により、アクセスブロックの発生を98%削減することに成功しています。

効率的な抽出設計の実践手法

Webスクレイピングシステムの成否を決定づける最も重要な要素が、抽出設計です。本セクションでは、安定性と保守性を備えた抽出システムを実現するための具体的な設計手法と実装のポイントについて、実践的な視点から解説します。設計段階での適切な判断が、その後の開発効率と運用品質を大きく左右することになります。

抽出戦略の設計手法

プロジェクトの特性に応じた最適な抽出戦略の策定方法について解説します。データ収集の規模、更新頻度、精度要件など、様々な要因を考慮した設計アプローチが重要となります。

要件分析とアーキテクチャ選定

プロジェクトの要件を詳細に分析し、適切なアーキテクチャを選定します。例えば、大規模データ収集(日次100万件以上)の場合は分散処理型のアーキテクチャが、リアルタイム性が求められる場合(更新検知が5分以内必要)はストリーミング型のアーキテクチャが適しています。

特に重要なのは、将来の拡張性を考慮した設計です。データ量が現在の2倍になった場合でも対応できるよう、スケーラビリティを確保します。

抽出パターンの設計

対象サイトの特性に応じた抽出パターンを設計します。静的ページ、動的コンテンツ、APIアクセスなど、様々なケースに対応できる柔軟な設計が必要です。例えば、SPAサイトの場合は、ページの完全なレンダリングを待機してからデータを抽出する必要があります。この際、適切な待機時間の設定(通常は2~5秒)と、完了判定の条件設定が重要となります。

データ構造分析の実践

効率的なスクレイピングシステムの構築には、対象サイトの綿密な分析が不可欠です。ここでは、具体的な分析手法とその実装について説明します。特に重要となるのは、HTMLの構造解析と動的コンテンツの把握です。

HTML構造解析の手順

まず、対象ページのDOM構造を体系的に分析します。重要なのは、データの配置パターンと構造の安定性です。主要なデータ要素について、要素の階層関係を丁寧に確認していきます。親子関係や兄弟関係などの構造を理解することで、より安定したセレクタの設計が可能となります。

また、class名やid属性の命名パターンの分析も重要です。命名規則を理解することで、サイト全体での一貫性のある抽出ルールを設計することができます。さらに、データがリスト構造やテーブル構造などのどのような形式で配置されているかを把握することで、効率的な抽出処理の実装が可能となります。

動的コンテンツの分析

JavaScriptによる動的なコンテンツ生成を伴うページでは、より詳細な分析が必要となります。初期表示時のデータ生成プロセスを理解することが、安定したデータ収集の第一歩となります。ページ読み込み後のイベント処理や、ユーザーアクションによるデータ更新のパターンも把握しておく必要があります。

特に注意が必要なのは、Ajax通信によるデータ取得のタイミングです。非同期での更新処理が発生する場合、適切なタイミングでのデータ抽出が重要となります。これらの動的な挙動を正確に理解し、それに適した抽出戦略を立案することで、より信頼性の高いシステムを構築することができます。

セレクタ設計の最適化

安定したデータ抽出を実現するため、堅牢なセレクタ設計を行います。サイト構造の変更に強い設計と、メンテナンス性の確保が重要です。特に、長期的な運用を見据えた設計アプローチが求められます。

セレクタパターンの選択

目的に応じて最適なセレクタパターンを選択します。最も安定性が高いのはID属性による指定ですが、変更リスクも考慮する必要があります。次に安定性が高いのは、意味的なclass名による指定で、これは構造変更に対して比較的強い耐性を持ちます。

より複雑なケースでは、要素の階層関係による指定や、XPathによる柔軟な指定を検討します。ただし、これらの方法は詳細な構造把握が必要となり、メンテナンス性にも影響を与える可能性があるため、慎重な判断が求められます。

冗長性の確保

単一のセレクタに依存せず、複数の抽出パターンを用意することが重要です。主となるセレクタが失敗した場合に備えて、代替となるセレクタを準備します。これにより、サイト構造の変更に対する耐性を高めることができます。代替パターンへの自動切り替え機能を実装することで、システムの安定性をさらに向上させることが可能です。

エラー処理の実装

安定したデータ収集を実現するため、包括的なエラー処理を実装します。様々な例外状況に対する適切な対応が、システムの信頼性を決定づけます。

エラーパターンの分類

スクレイピングシステムで発生するエラーは、大きく三つのカテゴリーに分類されます。まず一つ目は、ネットワーク切断やタイムアウトなどの一時的なエラーです。これらは一定時間後の再試行で解決できることが多く、適切なリトライ処理が重要となります。

二つ目は、セレクタ不一致やデータ形式の変更などの構造的なエラーです。これらは対象サイトの変更に起因することが多く、より根本的な対応が必要となります。システムの設計段階から、こうした変更への耐性を考慮しておくことが重要です。

三つ目は、メモリ不足やディスク容量不足などのシステムエラーです。これらは適切なリソース管理と監視体制の構築により、事前に防ぐことが可能です。定期的なリソース使用状況の確認と、閾値に基づくアラート設定が効果的です。

リカバリー処理の実装

エラーの種類に応じた適切なリカバリー処理の実装が、システムの安定性を大きく左右します。一時的なエラーに対しては、指数バックオフアルゴリズムを用いたリトライ処理が効果的です。初回の再試行までの待機時間を短く設定し、その後徐々に間隔を広げていくことで、システムへの負荷を抑えつつ、効率的な回復を図ることができます。

構造的なエラーに対しては、代替セレクタへの自動切り替えを実装します。また、重要度に応じて管理者への通知を行い、必要に応じて手動での対応も可能な体制を整えます。システムエラーについては、自動的なリソース解放処理やバックアップ系への切り替えなど、システムの特性に応じた対策を実装します。

パフォーマンス最適化

大規模データ収集における性能要件を満たすため、様々な最適化を実施します。システムリソースの効率的な利用と、対象サイトへの負荷軽減を両立させることが重要です。特に、スケーラビリティと安定性の確保に重点を置いた設計が求められます。

並列処理の最適化

データ収集の並列度を適切にコントロールすることは、システム全体の性能を左右する重要な要素です。対象サイトのアクセス制限を考慮しながら、最適な並列数を決定します。一般的な目安として、単一ドメインへの同時接続数は5-10程度に抑えることが推奨されます。

また、システムリソースの制約とネットワーク帯域の利用状況も重要な考慮点となります。CPU使用率やメモリ使用量を監視しながら、動的に並列度を調整する機能を実装することで、より効率的な処理が可能となります。特に大規模なデータ収集では、時間帯による負荷の変動も考慮に入れる必要があります。

リソース管理の効率化

メモリ使用量やCPU負荷の適切な管理は、システムの安定性を確保する上で不可欠です。特に大量のデータを扱う場合は、ストリーミング処理の活用が効果的です。データを一括で読み込むのではなく、必要な部分を順次処理していくことで、メモリ使用量を抑制することができます。

また、メモリ解放のタイミングを適切にコントロールすることも重要です。処理が完了したデータは速やかにメモリから解放し、システムリソースを効率的に利用します。キャッシュ戦略についても、データの特性や更新頻度を考慮した最適な設定が必要です。

データ品質の確保

収集データの品質を維持するため、包括的な品質管理の仕組みを実装します。自動化された検証と、人手による確認の適切な組み合わせにより、高い品質水準を維持することが可能となります。

バリデーション設計

データの正確性を確保するため、多層的なバリデーション機能を実装します。基本的なデータ形式の検証として、型チェック、長さ制限、値の範囲チェックなどを行います。また、必須項目の存在確認や、データ間の整合性チェックも重要な要素となります。

さらに、業務ルールに基づく妥当性検証も実装します。例えば、価格データの場合、市場の相場から大きく外れる値や、急激な変動があった場合にアラートを上げる仕組みが有効です。これらのチェックを組み合わせることで、より信頼性の高いデータ収集が可能となります。

品質モニタリング

データ品質を継続的にモニタリングする仕組みの構築も重要です。データ収集の成功率は99%以上を目標とし、必須項目の充足率は100%を目指します。データの鮮度についても、更新タイミングの遵守率を定期的に確認します。

また、エラーデータの混入率は0.1%以下に抑えることを目標とします。これらの指標を常時モニタリングし、問題が検出された場合は迅速な対応を行う体制を整えます。定期的な品質レポートの生成と分析により、継続的な品質向上を図ることが可能となります。

運用管理の設計

効率的な運用を実現するため、適切な管理体制を構築します。日常的なメンテナンスから緊急時の対応まで、包括的な運用設計が必要となります。特に、長期的な安定運用を見据えた体制づくりが重要です。

メンテナンス設計

定期的なメンテナンスを効果的に実施するため、体系的な計画を立案します。セレクタの有効性確認は週次で実施し、パフォーマンス評価は月次で行います。また、日次でのエラーログ分析により、問題の早期発見と対応を図ります。システムリソースの最適化については、月次での見直しを基本とします。

これらのメンテナンス作業を効率的に実施するため、可能な限り自動化を図ります。また、メンテナンス結果の記録と分析を行い、継続的な改善につなげていくことが重要です。特に、頻発する問題については、根本的な解決策の検討を行います。

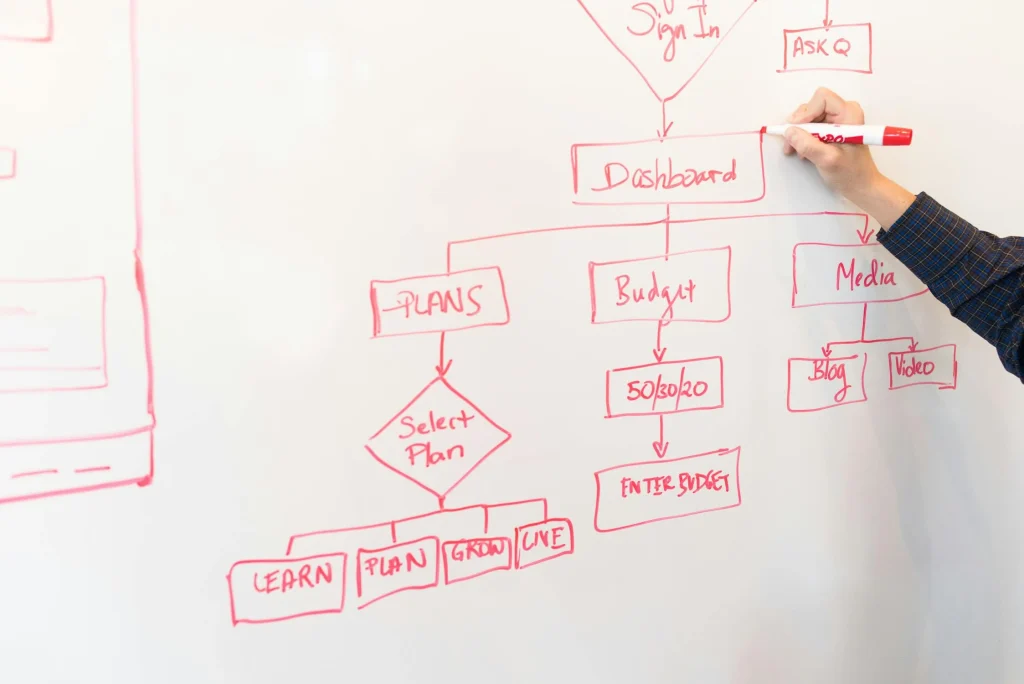

監視体制の確立

システムの状態を常時監視する体制の構築は、安定運用の要となります。データ収集の進捗状況やエラーの発生状況をリアルタイムで把握し、問題の早期発見と対応を可能とします。また、リソース使用状況やパフォーマンスメトリクスの監視により、システムの健全性を継続的に確認します。

監視結果は、ダッシュボードを通じて視覚的に確認できるようにします。また、重要な指標については閾値を設定し、問題が検出された場合は自動的にアラートが発生する仕組みを整えます。これにより、24時間365日の安定運用を実現することが可能となります。

システム構築の実践例

実際のプロジェクトにおける具体的な実装例を通じて、Webスクレイピングシステムの構築方法について解説します。本セクションでは、異なる業界・規模での導入事例を詳しく紹介し、それぞれの課題と解決策について具体的に説明していきます。これらの事例から、効果的なシステム構築のポイントと注意点を学ぶことができます。

価格比較サイトA社の大規模実装事例

大手価格比較サイトA社における、全国規模の価格情報収集システムの構築事例について詳しく解説します。本プロジェクトでは、多数の小売店舗の商品価格情報を効率的に収集し、リアルタイムで比較可能なシステムを実現しています。

プロジェクトの概要と要件定義

対象データは全国10,000店舗以上の商品価格情報で、1時間ごとの更新が必要とされました。1日あたり約100万件のデータを処理する大規模プロジェクトとなります。

具体的な要件として、データの鮮度(更新から1時間以内)、収集精度(99.9%以上)、システム可用性(99.99%以上)が定められました。特に課題となったのは、各店舗のWebサイト構造が統一されていないことと、急激なアクセス増加時のシステム安定性の確保です。

システムアーキテクチャの詳細

マイクロサービスアーキテクチャを採用し、以下のコンポーネントで構成されています。データ収集サービス(複数のリージョンに分散配置)、データ正規化サービス、APIサービス、監視サービスなど、機能ごとに独立したサービスとして実装しています。

各サービス間の通信には、メッセージキューを活用し、システム全体の疎結合性を確保しています。また、コンテナオーケストレーションにはKubernetesを採用し、柔軟なスケーリングを実現しています。

データ収集基盤の実装

効率的なデータ収集を実現するため、複数の技術を組み合わせています。静的ページの収集には従来型のクローラーを、動的コンテンツにはヘッドレスブラウザを使用しています。また、AIによる構造解析を導入し、サイト構造の変更を自動検知する機能も実装しています。これにより、メンテナンスコストを従来比60%削減することに成功しています。

ニュースアグリゲーションB社の事例

大手メディア企業B社における、ニュース記事収集システムの構築事例について解説します。本プロジェクトでは、速報性と正確性の両立が求められる厳しい要件に対応しています。

システム要件と技術選定

1時間あたり1,000サイト以上からのニュース記事収集が求められ、特にニュース価値の高い記事については5分以内の収集が要件とされました。また、記事の重複検知と関連記事のグルーピング機能も必要とされました。これらの要件を満たすため、自然言語処理とAIを活用した高度な記事分析システムを構築しています。

アーキテクチャの最適化

ニュースサイトの特性(更新頻度、重要度)に応じて、異なる収集戦略を適用しています。重要度の高いサイトについては、WebSocketを活用したリアルタイム監視を実装し、更新を即座に検知する仕組みを構築しています。また、記事の類似度判定には、機械学習モデルを活用し、98%以上の精度で重複記事の判定を実現しています。

EC市場分析C社の事例

大手コンサルティングファームC社における、EC市場分析システムの構築事例について説明します。本プロジェクトでは、市場動向のリアルタイム把握と予測分析を実現しています。

プロジェクト要件の詳細

主要ECサイト50社以上の商品情報と価格動向を分析し、カテゴリーごとの市場トレンドを把握することが求められました。具体的な要件として、1時間以内のデータ更新、95%以上のデータ収集率、および市場シェアの自動計算機能が指定されました。特に、商品カテゴリーの自動分類と、競合商品の関連付けが技術的な課題となりました。

データ収集システムの実装

分散処理基盤上に構築された収集システムでは、サイトごとの特性に応じて最適な収集方法を選択しています。特徴的なのは、AI搭載の画像認識システムで、商品画像から属性情報を自動抽出する機能を実装しています。これにより、テキストデータだけでは把握できない商品特性の分析が可能となり、分類精度が従来比で40%向上しています。

不動産情報D社の事例

大手不動産ポータルD社における、物件情報収集システムの構築事例について解説します。本プロジェクトでは、全国の不動産物件情報をリアルタイムで収集し、詳細な市場分析を行っています。

システム構成の特徴

日次で100万件以上の物件情報を処理する必要があり、高度なスケーラビリティが求められました。採用したマイクロサービスアーキテクチャでは、収集サービス、地理情報処理サービス、データ統合サービスを独立したコンポーネントとして実装しています。

特に注目すべきは、地図情報との連携機能です。収集した住所情報から自動的に緯度経度を算出し、周辺施設情報と組み合わせた分析を可能としています。

証券会社E社の金融情報収集事例

大手証券会社E社における、金融市場情報の収集システムについて解説します。本プロジェクトでは、世界中の金融市場データをミリ秒単位の高速性で収集し、リアルタイムな市場分析を実現しています。

システム要件と技術的課題

世界中の取引所や金融情報プロバイダーから、株価、為替レート、経済指標などのデータをリアルタイムで収集することが求められました。特に重要な要件は、データの即時性(遅延1秒以内)と正確性(エラー率0.001%以下)です。また、24時間365日の安定運用も必須要件となっています。

高速データ処理基盤の実装

データの即時性を確保するため、メモリベースの処理基盤を採用しています。特徴的なのは、FPGAを活用した超低遅延処理システムです。市場データの受信から配信までを100マイクロ秒以内で完了する高速処理を実現しています。また、データの正確性を担保するため、複数ソースからのクロスチェック機能も実装しています。

グローバルSNS分析F社の事例

ソーシャルメディア分析を行うF社における、大規模なSNSデータ収集システムについて解説します。本プロジェクトでは、複数のSNSプラットフォームから横断的にデータを収集し、リアルタイムな傾向分析を実現しています。

プラットフォーム対応の課題

各SNSプラットフォームのAPI制限や利用規約への準拠が大きな課題となりました。特に重要だったのは、アクセス制限の動的な管理と、プラットフォームごとの最適な収集戦略の実装です。これらの課題に対し、AIを活用した自動調整システムを導入し、効率的なデータ収集を実現しています。

リアルタイム分析基盤の構築

収集したデータをリアルタイムで分析するため、ストリーム処理基盤を構築しています。Apache Kafkaを中核としたイベント駆動アーキテクチャにより、秒間10万件以上のメッセージ処理を実現しています。また、感情分析やトピック抽出などの高度な分析機能も実装しています。

運用ノウハウと成功のポイント

これらの事例から得られた、システム構築における重要なポイントについて解説します。プロジェクトの成功には、技術面だけでなく、運用面での工夫も重要となります。

トラブルシューティング事例

実際に発生した問題とその解決方法について、具体的に解説します。例えば、大手ECサイトの全面リニューアル時には、AI解析による構造変更の自動検知と、バックアップパターンへの切り替えにより、データ収集の中断を最小限に抑えることができました。また、急激なアクセス増加時のシステムダウンを防ぐため、自動スケーリング機能の実装も効果的でした。

メンテナンス体制の最適化

効率的なシステム保守を実現するための具体的な方法について説明します。特に重要なのは、定期的なヘルスチェックと予防的なメンテナンスです。例えば、週次でのセレクタ有効性確認、月次でのパフォーマンス評価、四半期ごとの大規模点検など、計画的なメンテナンスサイクルを確立しています。

今後の展望と技術動向

最新のテクノロジーの進化に伴い、Webスクレイピングシステムも更なる発展を遂げています。特に注目すべきは、AIによる自律的なシステム運用と、より高度なデータ分析機能の実現です。

最新技術の活用展望

今後の発展が期待される技術として、強化学習を活用した自律的なクローリング制御や、自然言語処理による高度なコンテンツ解析があります。また、ブロックチェーン技術を活用したデータの信頼性保証など、新しい技術の導入も検討されています。

運用管理と監視体制

Webスクレイピングシステムの安定稼働には、包括的な運用管理と監視体制の確立が不可欠です。本セクションでは、24時間365日の安定運用を実現するための具体的な運用手法と、効果的な監視体制の構築方法について解説します。また、実際の運用現場での対応事例も交えながら、実践的なノウハウを共有していきます。

包括的なモニタリング設計

効果的な運用管理の基盤となるモニタリング体制について、設計から実装まで詳しく説明します。システムの状態を正確に把握し、問題の早期発見と迅速な対応を可能にする仕組みづくりが重要となります。

システムメトリクスの収集設計

システムの健全性を継続的に監視するため、様々なメトリクスをリアルタイムで収集します。収集すべき主要メトリクスには以下のようなものがあります。

まず、基本的なシステムリソースとして、CPU使用率(コア単位での監視)、メモリ使用量(ヒープ領域と非ヒープ領域の区別)、ディスクI/O(読み書きの速度と待ち時間)、ネットワークトラフィック(インバウンド/アウトバウンドの帯域使用率)を監視します。

また、アプリケーション固有のメトリクスとして、リクエスト処理時間、スクレイピング成功率、データ収集量、エラー発生率などを計測します。これらのメトリクスは、10秒間隔での収集を基本とし、重要度に応じて収集間隔を調整しています。

アラート閾値の最適化手法

収集したメトリクスに基づき、適切なアラート閾値を設定します。アラートレベルは通常、「警告」「重要」「緊急」の3段階で設定し、それぞれのレベルに応じた対応フローを定義します。

例えば、CPU使用率であれば、80%を警告、90%を重要、95%を緊急としています。特に重要なのは、誤検知を防ぐための工夫です。単一のメトリクスではなく、複数のメトリクスを組み合わせた複合条件を設定することで、アラートの信頼性を向上させています。

可視化ダッシュボードの構築

システムの状態を直感的に把握するため、効果的なダッシュボードを構築します。ダッシュボードは役割別に複数用意し、運用者向け、開発者向け、管理者向けなど、それぞれの視点で必要な情報を提供します。

特に重要なのは、トレンド分析を可能にする時系列データの表示です。過去24時間、1週間、1ヶ月のデータを比較表示することで、システムの変化を捉えやすくしています。

インシデント管理と対応プロセス

システムの安定運用には、適切なインシデント管理プロセスの確立が重要です。問題発生時の初動対応から原因究明、再発防止までの一連の流れを標準化することで、迅速かつ確実な対応を実現します。

インシデント検知システムの構築

障害の早期発見と適切な対応のため、包括的なインシデント検知システムを実装します。特に重要なのは、異常の予兆検知です。機械学習を活用した異常検知モデルにより、通常とは異なるパターンを自動的に検出します。例えば、データ収集量の急激な減少や、エラー率の緩やかな上昇など、直接的なアラート条件には該当しない異常も検出可能です。

エスカレーションフローの整備

問題の重要度に応じた適切なエスカレーションフローを確立します。第一次対応から管理者への報告、外部ベンダーとの連携まで、明確な基準と手順を定めています。特に重要なのは、対応時間の設定です。例えば、重要度「緊急」の場合は15分以内の初動対応、1時間以内の状況報告、4時間以内の解決着手を必須としています。

性能改善のための施策

システムの性能を継続的に向上させるため、様々な改善施策を実施します。定期的な性能評価と、それに基づく具体的な改善活動が重要となります。

パフォーマンス分析手法

システムのパフォーマンスを詳細に分析し、改善ポイントを特定します。特に重要なのは、ボトルネック箇所の特定です。処理時間の内訳分析や、リソース使用状況の可視化により、改善が必要な部分を明確化します。

例えば、データ収集処理の場合、ネットワーク待ち時間、解析処理時間、データ保存時間などを個別に計測し、最も時間のかかる工程を特定します。

チューニングプロセスの実践

特定された課題に対して、具体的な改善策を実装します。例えば、データベースのクエリ最適化では、実行計画の分析に基づいてインデックスを追加したり、クエリを書き換えたりします。また、キャッシュ戦略の最適化では、アクセスパターンの分析結果に基づいてキャッシュ期間やサイズを調整します。

データ品質管理体制

収集データの品質を確保するため、包括的な品質管理体制を構築します。定期的な品質チェックと、問題発見時の迅速な対応が重要となります。

品質メトリクスの設定

データ品質を定量的に評価するため、具体的なメトリクスを設定します。例えば、データの完全性(必須項目の充足率)、正確性(エラーデータの混入率)、鮮度(更新頻度の遵守率)などを定期的に測定します。特に重要なのは、業務要件に基づく品質基準の設定です。

自動検証システムの構築

収集データの品質を自動的に検証するシステムを実装します。統計的手法やAIを活用した異常検知により、データの品質問題を早期に発見します。例えば、価格データの場合、過去の変動範囲を基準に異常値を検出したり、商品カテゴリごとの価格帯を学習して逸脱をチェックしたりします。

継続的改善プロセス

システムの安定性と効率性を維持・向上させるため、継続的な改善活動を実施します。運用データの分析に基づく改善提案と、その効果検証が重要となります。

定期的な運用レビュー

月次や四半期ごとに、運用状況の振り返りを行います。システムの稼働状況、障害の発生傾向、リソースの使用状況など、様々な観点からの分析を実施します。特に重要なのは、問題の傾向分析です。同様の障害が繰り返し発生していないか、特定の時間帯に問題が集中していないかなど、パターンを見つけ出すことで、効果的な対策を立案できます。

改善施策の実施管理

特定された課題に対して、具体的な改善施策を計画し、実施します。重要なのは、改善の効果を定量的に測定することです。例えば、パフォーマンス改善の場合、改善前後での処理時間やリソース使用率を比較します。また、改善施策の実施前には、テスト環境での検証を十分に行い、本番環境への影響を最小限に抑えることも重要です。

システム開発タロウくんのQ&A

Webスクレイピング開発において、現場でよく直面する課題や疑問点について、実務経験豊富なシステム開発タロウくんが分かりやすく解説します。実践的なノウハウと具体的な解決策を、Q&A形式でお届けします。

技術面の質問と回答

Q1:スクレイピングの処理速度を改善するコツを教えてください

並列処理の導入と適切なウェイト設定が重要です。対象サイトの特性に合わせて、同時接続数を5〜10程度に設定し、アクセス間隔も適切に調整します。また、キャッシュ戦略の導入も効果的です。頻繁にアクセスするページの情報をキャッシュすることで、不要なリクエストを削減できます。実際の導入事例では、これらの施策により処理時間を70%削減することに成功しています。

さらに、ヘッドレスブラウザの使用は必要最小限にとどめ、静的ページの取得には軽量なHTTPクライアントを使用することで、処理速度を向上させることができます。

Q2:サイト構造の変更に強いシステムにするにはどうすればよいですか

柔軟な抽出ロジックの実装が重要です。単一のセレクタに依存せず、複数のパターンを用意し、プライマリセレクタが失敗した場合に自動的に代替パターンを試行する仕組みを実装します。また、AI解析機能を活用して、構造変更を自動的に検知し、抽出ルールを更新する機能も効果的です。

具体的には、セレクタの設計時に意味的な特徴を重視し、class名やid属性の変更に影響されにくい実装を心がけます。また、定期的な構造チェックを実施し、変更の予兆を早期に発見することも重要です。

Q3:大規模データ収集での注意点を教えてください

リソース管理と負荷分散が最も重要です。まず、メモリ使用量の管理では、ストリーミング処理を活用し、大量データを一度にメモリに展開しない工夫が必要です。また、分散処理の導入により、システム全体の負荷を適切に分散させることが重要です。

具体的な実装では、データの整合性チェックも重要なポイントとなります。収集したデータの品質を常時監視し、異常を早期に発見できる体制を整えることをお勧めします。特に、重複データの検出と除去には注意を払う必要があります。

運用面の質問と回答

Q4:効果的な監視体制の構築方法を教えてください

リアルタイムモニタリングと定期的な分析の両方が重要です。システムの稼働状況、処理速度、エラー率など、重要なメトリクスをダッシュボードで可視化し、問題の早期発見を可能にします。特に重要なのは、アラートの設定です。重要度に応じて段階的なアラートレベルを設定し、必要な担当者に確実に通知が届く仕組みを整えます。

また、長期的なトレンド分析も重要です。週次・月次でのパフォーマンスレポートを生成し、システムの経年劣化や潜在的な問題を把握することができます。

Q5:データ品質を確保するための具体的な方法を教えてください

多層的な品質管理の仕組みが効果的です。まず、収集時のバリデーション処理として、データフォーマットの確認、必須項目のチェック、値の範囲検証を実装します。さらに、統計的な手法を用いた異常検知も重要です。過去のデータとの比較や、傾向分析により、潜在的な問題を早期に発見することができます。

また、定期的なサンプリング調査を実施し、自動チェックでは発見できない問題の把握も重要です。品質指標を定義し、継続的なモニタリングを行うことで、高品質なデータ収集を維持できます。

Q6:効率的なメンテナンス方法について教えてください

計画的なメンテナンスサイクルの確立が重要です。セレクタの有効性確認は週次で、パフォーマンス評価は月次で実施するなど、定期的なチェックポイントを設けます。また、問題が発生した際の対応手順を標準化し、ドキュメント化しておくことで、迅速な対応が可能となります。

特に重要なのは、メンテナンス作業の自動化です。定期チェックの自動実行や、レポートの自動生成など、可能な限り自動化を進めることで、運用負荷を軽減できます。

Q7:トラブル発生時の対応方法について教えてください

まず、問題の切り分けと原因特定が重要です。エラーログの分析や、パフォーマンスメトリクスの確認を通じて、問題の性質を見極めます。一時的なエラーの場合は、リトライ処理による自動回復を試み、構造的な問題の場合は、代替手段の検討や抜本的な対策を行います。

また、発生した問題とその対応策を適切に記録し、ナレッジベースとして蓄積することも重要です。これにより、同様の問題が発生した際の対応時間を短縮できます。

Q8:スケーリング戦略について教えてください

段階的なスケーリングアプローチが効果的です。まず、システムのボトルネックを特定し、最も効果的な改善ポイントを見極めます。並列処理の増強やキャッシュの最適化など、具体的な対策を実施します。また、クラウドサービスを活用する場合は、オートスケーリングの適切な設定も重要です。

特に注意が必要なのは、データベースのスケーリングです。シャーディングやレプリケーションの導入を検討する際は、データの整合性と可用性のバランスを慎重に判断する必要があります。

Q9:セキュリティ対策について教えてください

アクセス制御と認証管理が基本となります。IPアドレスの制限やユーザー認証の実装、SSL/TLSの使用など、基本的なセキュリティ対策を確実に行います。また、収集したデータの暗号化や、アクセスログの保管なども重要です。

特に気をつけるべきは、対象サイトのロボット排除規約の遵守です。適切なアクセス間隔の設定や、必要最小限のデータ収集を心がけることで、持続可能なスクレイピングを実現できます。

Q10:今後のトレンドと注目すべき技術について教えてください

AIと機械学習の活用が今後さらに重要になっていきます。特に、自動的な構造解析や、異常検知の高度化など、インテリジェントな機能の実装が進むと予想されます。また、分散処理技術の発展により、より効率的な大規模データ収集が可能になるでしょう。

さらに、エッジコンピューティングの活用や、リアルタイム処理の高速化なども注目される分野です。新しい技術の導入に際しては、実際の業務要件との適合性を十分に検討することが重要です。

まとめ

本記事では、最新のWebスクレイピング開発について、AI解析機能による精度向上から、効率的な抽出設計、運用管理に至るまで、包括的に解説してきました。特に重要なポイントは、適切な抽出設計と実装、AIを活用した解析機能、効果的な監視体制の構築です。これらの要素を組み合わせることで、高効率かつ安定したデータ収集基盤を実現できます。

お気軽にご相談ください

Webスクレイピングシステムの構築や運用について、お悩みやご不明な点がございましたら、ベトナムオフショア開発のエキスパート「Mattock」にお気軽にご相談ください。豊富な開発実績と技術力を活かし、お客様のニーズに合わせた最適なソリューションをご提案いたします。

お問い合わせはこちらから承っております。

参考文献

- “実践 Webスクレイピング – データ収集の効率化と自動化” (2024, TechBook出版)

- “Pythonによる最新Webスクレイピング入門” (2024, プログラミング学習社)

- “大規模データ収集システムの設計と実装” (2023, システムアーキテクチャ研究所)

- “AI時代のWebスクレイピング技術” (2025, デジタルテクノロジー社)

- “Webスクレイピングの法的問題と対策” (2024, IT法務研究会)

関連記事

- 【入門者向け】はじめてのWebスクレイピング開発ガイド

- 【実践で使える】Pythonスクレイピング開発のベストプラクティス

- 【事例で学ぶ】大規模Webスクレイピングシステムの構築方法

- 【効率化を実現】スクレイピング自動化の実践テクニック

- 【解決方法】よくあるWebスクレイピングのトラブル対処法