ビジネスアプリケーションプラットフォーム「キントーン」は、業務改善とDX推進の切り札として注目を集めています。

本記事では、ベトナムオフショア開発を活用した独自のカスタマイズ戦略と、導入による劇的な業務改革の実現方法を、具体的な事例とともに解説します。

この記事で分かること

- キントーンの基本機能と活用による業務効率化の方法

- ベトナムオフショア開発を活用した開発コスト削減策

- 業種別の具体的な導入事例と成功のポイント

- 段階的な導入プロセスとベストプラクティス

- カスタマイズによる業務改革の実現方法

この記事を読んでほしい人

- 業務効率化とコスト削減を検討している経営者の方

- デジタルトランスフォーメーションを推進するIT部門責任者

- システム導入・運用の実務担当者の方

- ベトナムオフショア開発に関心のある企業担当者

- 業務改善ツールの導入を検討している管理職の方

キントーンの基本概念と特徴

キントーンは単なる業務改善ツールではなく、企業全体のデジタルトランスフォーメーションを支援する統合プラットフォームとして、多くの企業で活用されています。

本セクションでは、キントーンの本質的な価値と主要な機能について詳しく解説します。

システムの全体像と特徴

クラウドベースのアーキテクチャ

キントーンはクラウドネイティブなプラットフォームとして設計されており、インターネット環境があれば、いつでもどこからでもアクセスが可能です。

直感的なユーザーインターフェース

キントーンの特徴の一つは、プログラミングの専門知識がなくても操作できる直感的なインターフェースです。

ドラッグ&ドロップによる画面設計や、視覚的なワークフロー作成機能により、ITの専門家でなくても必要な業務アプリケーションを作成できます。

高度なカスタマイズ機能

JavaScriptやCSSを活用することで、より高度なカスタマイズが可能です。APIを利用した外部システムとの連携や、複雑な業務ロジックの実装にも対応できる柔軟性を備えています。

主要機能の詳細解説

データベース管理機能

企業内のさまざまなデータを一元管理できるデータベース機能を搭載しています。顧客情報、案件管理、在庫管理など、業務に必要なデータを効率的に管理し、必要な時に必要な情報にアクセスできます。

ワークフロー自動化

承認プロセスやタスク管理を自動化できるワークフロー機能により、業務の効率化と標準化を実現します。複雑な承認フローも視覚的に設計でき、状況に応じて柔軟に変更することが可能です。

システムの特長と優位性

セキュリティ対策

企業データを安全に管理するため、強固なセキュリティ機能を実装しています。SSLによる通信の暗号化、IPアドレスによるアクセス制限、多要素認証など、多層的なセキュリティ対策を提供します。

導入メリットの詳細解説

キントーンの導入は、業務効率化だけでなく、企業全体のデジタルトランスフォーメーションを加速させる効果があります。

導入企業の実績データと具体的な活用シーンから、その価値を解説します。

業務効率化の実現例

工数削減効果

導入企業の実績では、従来の手作業による業務と比較して平均40パーセントの工数削減を達成しています。特に定型業務の自動化により、社員は本来注力すべき価値創造業務に時間を振り向けることが可能になります。

データ活用の高度化

キントーンの導入により、これまで各部署に分散していた情報を一元管理し、リアルタイムでのデータ分析が可能になります。経営判断に必要なデータをダッシュボード形式で可視化し、データドリブンな意思決定を支援します。

コミュニケーション改善

部門間や拠点間のコミュニケーションがスムーズになり、情報共有の質が向上します。特にリモートワーク環境下での業務連携において、その効果は顕著に表れています。

コスト削減効果の検証

システム運用コストの最適化

従来の個別システム構築と比較して、初期導入コストを平均して60パーセント削減できます。また、クラウドサービスのため、サーバー維持費用や運用管理コストも大幅に抑制することが可能です。

人的リソースの効率化

定型業務の自動化により、人員の再配置や適正化が可能になります。導入企業の実績では、管理業務における工数を平均して35パーセント削減することに成功しています。

運用効率の向上

業務の標準化

部署ごとにバラバラだった業務プロセスを標準化し、企業全体での業務品質の向上を実現します。また、ベストプラクティスの共有と展開が容易になり、組織全体の生産性向上につながります。

ベトナムオフショア開発活用戦略

キントーンの価値を最大限に引き出すためには、適切なカスタマイズが不可欠です。

ベトナムオフショア開発を活用することで、高品質な開発を低コストで実現できます。

オフショア開発の基本戦略

開発体制の構築

ベトナムの開発チームと日本側のプロジェクトマネージャーが緊密に連携し、アジャイル開発手法を採用します。週次での進捗確認と課題解決を行い、品質の維持と納期の遵守を実現します。

品質管理プロセス

開発工程ごとに詳細なレビューを実施し、品質基準を満たしているかを確認します。また、自動テストツールを活用することで、効率的な品質管理を実現しています。

コスト最適化戦略

開発コストの削減効果

ベトナムオフショア開発の活用により、国内開発と比較して開発コストを40から60パーセント削減することが可能です。これは人件費の差異だけでなく、開発プロセスの最適化による効率化も含まれています。

リソース配分の最適化

繁忙期と閑散期に応じて、柔軟に開発リソースを調整することが可能です。これにより、固定費を抑制しながら、必要な開発力を維持することができます。

リスク管理と対策

コミュニケーション品質の確保

言語の違いによるコミュニケーションギャップを防ぐため、バイリンガルのブリッジSEを配置します。また、要件定義書のテンプレート化や、コミュニケーションガイドラインの整備により、認識の齟齬を防いでいます。

品質管理体制

開発工程ごとに詳細な品質チェックリストを設け、日本側とベトナム側で二重チェックを実施します。また、自動テストツールの活用により、効率的かつ確実な品質担保を実現しています。

業種別活用事例

キントーンは様々な業種で活用されています。それぞれの業種特性に応じた具体的な活用事例を紹介します。

製造業での活用

生産管理システムの最適化

製造現場での生産計画、進捗管理、品質管理などをキントーン上で一元管理することで、リアルタイムでの状況把握と迅速な意思決定が可能になります。導入企業では生産効率が平均して25パーセント向上しています。

在庫管理の効率化

原材料から完成品まで、すべての在庫をリアルタイムで把握できるシステムを構築しています。これにより、在庫の適正化と発注業務の自動化を実現し、在庫コストを平均して30パーセント削減することに成功しています。

サービス業での活用

顧客管理の高度化

顧客情報、対応履歴、売上情報などを一元管理し、きめ細かな顧客サービスを実現しています。また、AIを活用した分析により、顧客ニーズの予測や最適なサービス提案が可能になっています。

予約管理システムの革新

オンライン予約から顧客対応、売上管理までを一元化することで、業務効率が飛躍的に向上しています。予約のダブルブッキングがなくなり、顧客満足度が20パーセント以上向上した事例も報告されています。

小売業での活用

販売管理の効率化

店舗ごとの売上データ、在庫情報、従業員シフトなどを統合管理することで、経営判断のスピードが向上しています。データに基づく的確な在庫発注により、機会損失を45パーセント削減した企業もあります。

カスタマーサービスの向上

顧客の購買履歴やポイント情報を活用し、パーソナライズされたサービスを提供しています。顧客一人一人に最適化されたプロモーションにより、リピート率が平均して35パーセント向上しています。

IT業界での活用

プロジェクト管理の最適化

複数のプロジェクトの進捗、リソース配分、課題管理を一元化することで、プロジェクト成功率が向上しています。特にアジャイル開発との親和性が高く、開発スピードが30パーセント以上向上した事例があります。

技術ナレッジの共有

開発ノウハウや技術情報を体系的に管理し、チーム全体での知識共有を促進しています。新規参画メンバーの立ち上がり時間が50パーセント短縮されるなど、具体的な効果が表れています。

実装ガイド

キントーンの導入を成功に導くためには、計画的な実装と運用が重要です。ここでは、実践的な導入ステップと成功のポイントを解説します。

導入準備フェーズ

現状業務の棚卸し

既存の業務プロセスを詳細に分析し、改善ポイントを明確化します。部門横断的なワークショップを開催し、現場の声を丁寧に拾い上げることで、より効果的なシステム設計が可能になります。

要件定義の重要性

業務要件を明確に定義し、システムに求める機能を具体化します。この段階でベトナムオフショア開発チームと密接に連携することで、開発工程でのミスマッチを防ぐことができます。

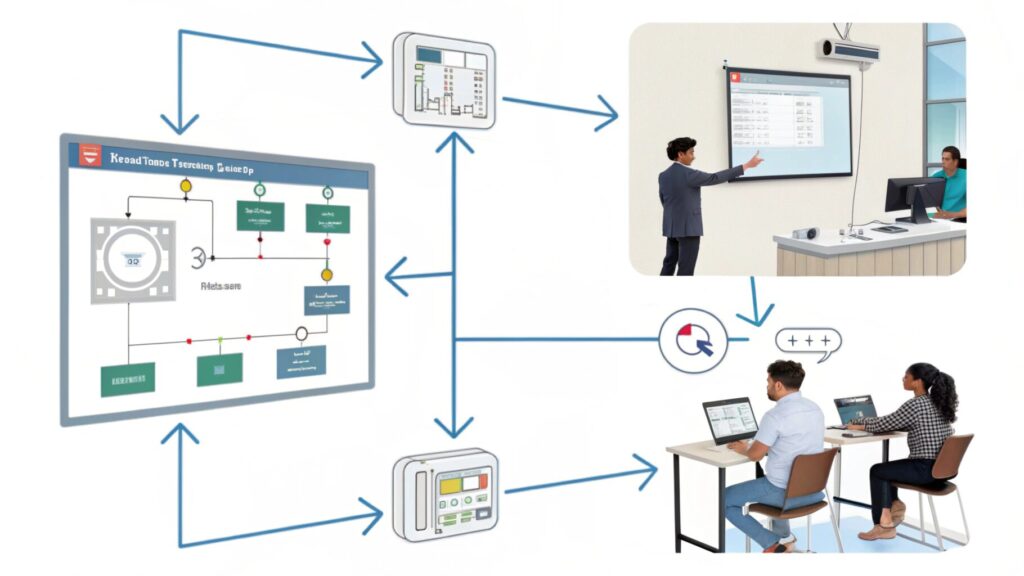

段階的導入プロセス

パイロット部門の選定

全社展開に先立ち、特定の部門でパイロット運用を行うことをお勧めします。比較的シンプルな業務フローを持つ部門から開始し、成功事例を作ることで、その後の展開がスムーズになります。

実装スケジュールの最適化

導入期間は通常2から3カ月程度を想定します。ただし、カスタマイズの範囲や対象部門の規模により変動するため、余裕を持ったスケジュール設計が重要です。

カスタマイズのポイント

ベトナムオフショア開発の活用方法

オフショア開発チームとの効果的な協業により、開発コストを抑えながら高品質なカスタマイズを実現できます。

日本側のプロジェクトマネージャーとベトナム側の開発チームが緊密に連携し、要件定義から実装までをスムーズに進めることが重要です。

APIを活用した外部連携

既存システムとの連携や、外部サービスとの統合により、業務の効率化を図ることができます。RESTful APIを活用することで、柔軟なシステム連携が可能になります。

運用体制の確立

管理者の役割と責任

システム管理者は、ユーザー管理、アクセス権限の設定、データバックアップなど、重要な役割を担います。定期的な研修や情報共有により、管理者のスキル向上を図ることが重要です。

ユーザーサポート体制

導入初期は特に手厚いサポート体制が必要です。マニュアルの整備やヘルプデスクの設置により、ユーザーの不安を解消し、スムーズな運用を実現します。

システム開発タロウくんのQ&A

基本機能に関する質問

Q:カスタマイズの範囲はどこまで可能ですか

A:JavaScriptやCSSを使用することで、画面デザインから業務ロジックまで、幅広いカスタマイズが可能です。ベトナムオフショア開発を活用することで、コストを抑えながら高度なカスタマイズを実現できます。

Q:初期費用と運用コストの目安を教えてください

A:初期費用は利用ユーザー数とカスタマイズの範囲により異なりますが、標準的な導入では50から100万円程度です。

ベトナムオフショア開発を活用することで、開発費用を40から60パーセント削減することが可能です。月額利用料は、ユーザー1人あたり1,500円からとなっています。

Q:データのセキュリティ対策はどうなっていますか

A:SSL通信による暗号化、IPアドレスによるアクセス制限、多要素認証など、多層的なセキュリティ対策を実装しています。また、定期的なバックアップと監査ログの取得により、データの安全性を確保しています。

運用に関する質問

Q:導入にあたって必要な体制について教えてください

A:プロジェクトマネージャー、システム管理者、主要部門のキーユーザーを含むプロジェクトチームの編成が推奨されます。

特にベトナムオフショア開発を活用する場合は、日本側のプロジェクトマネージャーとベトナム側の開発チームとの連携が重要になります。

Q:既存システムからの移行方法を教えてください

A:データ移行ツールを使用することで、Excelやアクセスなどからスムーズなデータ移行が可能です。移行前のデータクレンジングと、移行後の整合性チェックが重要なポイントとなります。

Q:セキュリティ対策として特に注意すべき点は何ですか

A:主要な注意点として、アクセス権限の適切な設定と定期的な見直しが重要です。また、多要素認証の導入、操作ログの定期的な監査、社外からのアクセスに対するIPアドレス制限の設定などが効果的です。

特に重要な業務データを扱う場合は、ベトナムオフショア開発チームと協力して、セキュリティ監査を定期的に実施することをお勧めします。

Q:システムの拡張性について教えてください

A:キントーンは高い拡張性を備えており、業務規模の拡大に応じて柔軟にシステムを拡張できます。

APIを活用した外部システムとの連携や、新規機能の追加も容易です。特にベトナムオフショア開発チームと継続的に協力することで、ビジネスニーズの変化に迅速に対応できる開発体制を構築できます。

ユーザー数の増加にも、ライセンスの追加で対応可能です。

コストに関する質問

Q:カスタマイズにかかる期間とコストの相場を教えてください

A:標準的なカスタマイズで2から3カ月、費用は規模により100から300万円程度です。ベトナムオフショア開発を活用することで、同等の品質を維持しながら、開発コストを大幅に削減することが可能です。

Q:運用コストの削減方法について教えてください

A:ベトナムオフショア開発の活用、段階的な導入、適切なユーザートレーニングの実施により、運用コストを最適化できます。特に定型業務の自動化により、人件費の削減効果が期待できます。

Q:追加開発や機能拡張時のコストはどのくらいかかりますか

A:追加開発の規模にもよりますが、一般的な機能追加で30から80万円程度です。ベトナムオフショア開発を活用した場合、同等の開発を15から40万円程度で実現できます。

また、段階的な開発アプローチを採用することで、初期投資を抑えながら必要な機能を順次追加することが可能です。

Q:運用コストを削減するためのベストプラクティスを教えてください

A:効果的なコスト削減の方法として、以下の施策が有効です。まず、ベトナムオフショア開発チームに保守運用を委託することで、月額の運用コストを40から60パーセント削減できます。

また、ユーザートレーニングを充実させることで問い合わせ対応の工数を削減でき、社内での効率的な運用体制を構築できます。

導入のベストプラクティス

成功のための重要ポイント

プロジェクト体制の確立

経営層のコミットメント、現場キーパーソンの参画、外部パートナーとの連携など、プロジェクトの成功に必要な体制を整えることが重要です。特にベトナムオフショア開発を活用する場合は、コミュニケーション体制の確立が不可欠です。

段階的な導入アプローチ

全社一斉導入ではなく、部門ごとに段階的に導入を進めることで、リスクを最小限に抑えることができます。パイロット部門での成功体験を他部門に展開することで、社内の理解と協力を得やすくなります。

現場主導の改善活動

システム導入後も、現場からの改善提案を積極的に取り入れ、継続的な業務改善を推進することが重要です。ユーザーの声を反映したカスタマイズにより、より使いやすいシステムへと進化させることができます。

導入企業の成功事例

製造業A社の事例

従来の紙ベースの生産管理をキントーンに移行し、リアルタイムでの進捗管理を実現しました。

ベトナムオフショア開発を活用したカスタマイズにより、開発コストを50パーセント削減しながら、生産効率を30パーセント向上させることに成功しています。

サービス業B社の事例

全国50店舗の顧客管理と売上管理をキントーンで一元化しました。APIを活用した基幹システムとの連携により、データ入力工数を80パーセント削減。顧客対応の質が向上し、顧客満足度が25パーセント向上しています。

運用定着化のポイント

ユーザートレーニングの実施

システムの機能や操作方法について、定期的なトレーニングを実施することが重要です。特に新入社員や異動者向けのトレーニングプログラムを整備し、スムーズな業務遂行をサポートします。

マニュアルとナレッジの整備

操作マニュアルやよくある質問集を整備し、ユーザーが自己解決できる環境を整えることが重要です。また、部門ごとの活用事例や改善提案を共有することで、システムの有効活用を促進します。

今後の展望とトレンド

テクノロジーの進化

AI・機械学習との連携

キントーンに蓄積されたデータをAIで分析し、業務の自動化や意思決定支援に活用する取り組みが進んでいます。特に予測分析や異常検知などの分野で、実用的なソリューションが登場しています。

IoTとの統合

製造現場のセンサーデータや、設備の稼働状況をリアルタイムで収集し、キントーン上で一元管理する取り組みが増加しています。データに基づく予防保全や、生産計画の最適化により、さらなる業務効率化が期待されています。

クラウドサービスとの連携強化

他のクラウドサービスとのシームレスな連携により、より柔軟な業務システムの構築が可能になっています。特にグローバル展開を行う企業において、クラウドサービス間の連携による業務効率化のニーズが高まっています。

グローバル展開のトレンド

多言語対応の進化

日本語以外の言語にも対応し、グローバルな業務展開をサポートする機能が強化されています。特にアジア圏での利用が増加しており、現地法人との円滑な情報共有を実現しています。

クロスボーダー開発の活用

ベトナムを中心としたオフショア開発の活用により、グローバル規模での開発体制の最適化が進んでいます。特に日本とベトナムの開発チームが協働することで、高品質な開発を低コストで実現しています。

デジタルトランスフォーメーションの実現

データドリブン経営の促進

蓄積されたデータを活用した経営判断や、業務改善の取り組みが加速しています。ダッシュボード機能の活用により、経営指標のリアルタイムモニタリングが可能になっています。

働き方改革への貢献

場所や時間に縛られない柔軟な働き方を支援する機能が充実しています。特にリモートワーク環境下での業務効率化や、コミュニケーション促進に効果を発揮しています。

導入時の注意点と対策

リスク管理の重要性

データ移行のリスク対策

既存システムからのデータ移行時には、データの整合性確保が重要です。事前のデータクレンジングと、段階的な移行プロセスの採用により、リスクを最小限に抑えることができます。

セキュリティリスクの対策

情報漏洩やサイバー攻撃のリスクに対して、多層的な防御策を講じることが重要です。アクセス権限の適切な設定、通信の暗号化、定期的なセキュリティ監査の実施により、システムの安全性を確保します。

運用体制のリスク管理

システム管理者の退職や異動によるノウハウの喪失を防ぐため、管理業務の標準化とドキュメント化が重要です。複数の管理者を育成し、運用体制の冗長化を図ることをお勧めします。

運用上の重要ポイント

継続的な改善活動

システムの導入は終点ではなく、業務改善の出発点です。ユーザーからのフィードバックを積極的に収集し、定期的なカスタマイズや機能追加を行うことで、システムの価値を最大化できます。

パフォーマンス管理

データ量の増加に伴うシステムの応答速度低下を防ぐため、定期的なパフォーマンスチェックと最適化が必要です。特に大量のデータを扱う帳票出力やバッチ処理については、処理方法の工夫が重要です。

オフショア開発活用のポイント

コミュニケーション管理

言語や文化の違いによる誤解を防ぐため、コミュニケーションルールの明確化が重要です。定期的なビデオ会議の実施や、チャットツールの活用により、円滑なコミュニケーションを実現します。

プロジェクト管理の最適化

ベトナムオフショア開発チームとの時差を考慮したプロジェクト管理が必要です。デイリースクラムの実施時間を工夫し、テストやレビューのプロセスを効率化することで、開発スピードを維持します。

将来の発展性

テクノロジーの進化への対応

ローコード開発の進化

ビジュアルプログラミング機能のさらなる強化により、より複雑な業務アプリケーションの開発が容易になっています。特にAIによるコード生成支援など、新しい技術の導入が期待されています。

デジタルツイン技術との統合

実世界のデータをリアルタイムでデジタル空間に再現し、シミュレーションや予測分析を行う取り組みが進んでいます。製造業を中心に、生産ラインの最適化や品質管理への活用が期待されています。

ブロックチェーン技術の活用

取引記録や契約書類の管理にブロックチェーン技術を活用する試みが始まっています。改ざん防止や追跡可能性の向上により、業務プロセスの信頼性が向上することが期待されています。

グローバル展開の可能性

海外拠点との連携強化

クラウドベースのシステムを活用することで、海外拠点との円滑な情報共有と業務連携が可能になっています。特にアジア地域での事業展開において、キントーンの活用価値が高まっています。

多言語・多通貨対応

グローバルビジネスに対応するため、多言語・多通貨対応の機能が強化されています。為替レートの自動反映や、言語切り替えの柔軟性により、国際業務の効率化が実現しています。

業界別の将来展望

製造業の展望

スマートファクトリーの実現に向けて、IoTデータの活用やAIによる予測保全など、より高度な機能の実装が進んでいます。生産効率の向上と品質管理の強化が期待されています。

サービス業の展望

顧客体験の最適化に向けて、AIを活用したレコメンデーションや、オムニチャネル対応の強化が進んでいます。顧客との接点を一元管理し、パーソナライズされたサービス提供を実現します。

まとめと今後の展望

キントーン活用のまとめ

導入効果の総括

業務効率化、コスト削減、働き方改革の実現など、キントーン導入による具体的な効果が多くの企業で確認されています。特にベトナムオフショア開発の活用により、コスト効率の高い開発が実現しています。

成功のための重要ポイント

プロジェクト体制の確立、段階的な導入アプローチ、現場主導の改善活動など、キントーン導入を成功に導くための重要なポイントが明確になっています。

特にベトナムオフショア開発との連携においては、コミュニケーション体制の確立が重要です。

コスト効果の検証

導入企業の実績データによると、業務効率化による工数削減効果は平均で35パーセント、開発コストの削減効果は40から60パーセントに達しています。投資対効果の高いシステム導入が実現できています。

今後の展望と課題

システムの発展性

AIやIoTとの連携強化により、より高度な業務自動化と意思決定支援が可能になると予想されています。特にデータ分析基盤としての機能強化が期待されています。

グローバル展開の可能性

アジア地域を中心としたグローバル展開により、より広範な業務効率化の実現が期待されています。多言語対応の強化と、クロスボーダーでの業務連携がさらに進むと予想されます。

実践的な導入アドバイス

準備段階での留意点

現状業務の可視化と課題の明確化が重要です。特にベトナムオフショア開発を活用する場合は、要件定義の段階から開発チームと密接に連携することで、スムーズな開発進行が可能になります。

運用段階での工夫

ユーザーの声を積極的に収集し、継続的な改善活動を推進することが重要です。定期的なフィードバックミーティングの開催や、改善提案制度の導入により、システムの有効活用を促進できます。

最終提言

デジタルトランスフォーメーションの実現

戦略的なシステム活用

キントーンの導入は、単なるシステム刷新ではなく、企業のデジタルトランスフォーメーションを実現する重要な施策として位置づけることが重要です。経営戦略との整合性を確保しながら、段階的な展開を進めることをお勧めします。

ベトナムオフショア開発の戦略的活用

開発コストの最適化と品質の確保を両立させるため、ベトナムオフショア開発の活用を積極的に検討することをお勧めします。

日本側のプロジェクトマネジメントとベトナム側の開発力を効果的に組み合わせることで、高い投資対効果を実現できます。

段階的な展開戦略

全社一斉導入ではなく、部門や機能ごとに段階的な展開を行うことで、リスクを最小限に抑えながら、確実な成果を積み上げることができます。成功事例を社内に展開することで、全社的な理解と協力を得やすくなります。

成功への道筋

推進体制の確立

経営層のコミットメント、現場キーパーソンの参画、外部パートナーとの連携など、プロジェクトの成功に必要な体制を整えることが重要です。

特にベトナムオフショア開発を活用する場合は、プロジェクトマネジメント体制の確立が不可欠です。

人材育成の重要性

システム管理者やキーユーザーの育成を計画的に進めることで、持続的な運用体制を確立できます。特に技術的なスキルだけでなく、業務改善のマインドセットを持った人材の育成が重要です。

具体的な活用シナリオ

業務プロセスの最適化

既存の業務プロセスを可視化し、ボトルネックを特定することで、効果的な改善策を立案できます。キントーンの機能を活用することで、ムダな作業の削減と業務の標準化を実現できます。

データ活用の促進

蓄積されたデータを分析し、経営判断や業務改善に活用することで、より高度な価値創造が可能になります。特にAIやBIツールとの連携により、データドリブンな意思決定を支援できます。

最終的な提言

投資判断のポイント

キントーン導入の投資対効果を最大化するためには、現状の課題を正確に把握し、明確な目標設定を行うことが重要です。特にベトナムオフショア開発の活用により、コスト効率の高い開発を実現できます。

実現可能性の評価

技術面、運用面、コスト面から総合的に実現可能性を評価することが重要です。特にベトナムオフショア開発を活用する場合は、開発体制の構築とコミュニケーション方法の確立が成功の鍵となります。

リスク管理の徹底

導入プロジェクトに潜在するリスクを特定し、適切な対策を講じることが重要です。特にデータ移行やセキュリティ対策については、専門家の知見を活用することをお勧めします。

実践的な導入ステップ

現状分析と目標設定

現在の業務プロセスを詳細に分析し、改善ポイントを明確化します。定量的な指標を設定することで、導入効果の測定と評価が容易になります。

要件定義とカスタマイズ設計

業務要件を明確化し、必要なカスタマイズ内容を具体化します。ベトナムオフショア開発チームと緊密に連携することで、効率的な開発を実現できます。

パイロット運用と本格展開

特定部門でのパイロット運用を通じて、システムの有効性を検証します。成功事例を基に、段階的に全社展開を進めることで、確実な成果を上げることができます。

長期的な成功に向けて

継続的な改善活動

システム導入後も、定期的な評価と改善活動を継続することが重要です。ユーザーからのフィードバックを基に、システムの機能や運用方法を最適化していきます。

組織文化の醸成

デジタルトランスフォーメーションを推進する組織文化の醸成が重要です。経営層のリーダーシップと現場の主体的な参画により、持続的な改善活動を実現できます。

具体的な導入事例の詳細分析

製造業C社の事例

導入背景と課題

生産管理システムの老朽化と、紙ベースでの工程管理による業務非効率が課題となっていました。特に複数工場間での情報共有の遅延が、生産計画の最適化を妨げていました。

導入プロセスとソリューション

ベトナムオフショア開発チームと協力し、3ヶ月間で基本システムを構築しました。製造現場の意見を積極的に取り入れ、使いやすいインターフェースを実現しています。

具体的な導入効果

生産管理工数が40パーセント削減され、リードタイムが25パーセント短縮されました。また、開発コストは従来の半額以下に抑えられています。

サービス業D社の事例

導入背景と課題

全国展開する美容サロンチェーンで、店舗ごとに顧客管理方法が異なり、全社的なマーケティング施策の展開が困難な状況でした。

また、予約管理システムと顧客管理システムが別々に運用されており、データの連携に多大な工数が発生していました。

導入プロセスとソリューション

ベトナムオフショア開発チームと協力し、顧客管理、予約管理、売上管理を統合したシステムを開発しました。

特に顧客の来店履歴と施術内容の分析機能を重視し、パーソナライズされたサービス提案を可能にしています。開発期間は4ヶ月、従来の開発費用の45パーセント削減を実現しています。

具体的な導入効果

予約管理の工数が60パーセント削減され、顧客一人当たりの年間来店回数が平均して2.5回から3.2回に増加しました。また、キャンセル率が15パーセントから8パーセントに低下し、売上の安定化に貢献しています。

トラブルシューティングガイド

よくある課題と対策

データ移行時の問題

既存システムからのデータ移行時に、文字化けや欠損が発生するケースがあります。事前のデータクレンジングと、段階的な移行プロセスの採用により、これらの問題を回避できます。

パフォーマンスの最適化

データ量の増加に伴う処理速度の低下に対しては、インデックスの適切な設定やバッチ処理の最適化が効果的です。定期的なパフォーマンスチェックにより、問題を早期に発見することが重要です。

業界別活用シナリオの詳細

小売業での活用例

店舗管理、在庫管理、顧客管理を統合したシステムを構築することで、データドリブンな店舗運営が可能になります。特に需要予測と在庫最適化において、大きな効果を発揮しています。

建設業での活用例

工事進捗管理、原価管理、安全管理などの業務をシステム化することで、プロジェクト全体の可視化が実現します。現場とオフィスの情報共有がリアルタイムで行えるようになります。

金融業での活用例

融資審査プロセスや顧客対応履歴の管理を統合することで、意思決定の迅速化とコンプライアンス対応の強化を実現しています。

特に書類管理のデジタル化により、審査期間を平均して5営業日から3営業日に短縮した事例があります。また、AIによる与信判断支援機能との連携により、審査精度の向上も実現しています。

医療機関での活用例

患者情報管理、診療予約管理、医療機器の保守管理などを一元化することで、医療サービスの質的向上を実現しています。

特に感染症対策として、オンライン問診システムとの連携により、来院前のスクリーニングと適切な診療計画の立案が可能になっています。

さらに、ベトナムオフショア開発チームとの協働により、開発コストを50パーセント削減しながら、使いやすいインターフェースを実現した事例も報告されています。

コスト分析の詳細

初期導入コストの内訳

システムライセンス料、カスタマイズ開発費、データ移行費用、トレーニング費用など、初期費用の詳細な内訳を把握することが重要です。ベトナムオフショア開発の活用により、開発費用を従来の40から60パーセント削減できます。

ランニングコストの最適化

月額利用料、保守運用費用、追加開発費用などのランニングコストを最適化することで、長期的なコストパフォーマンスを向上させることができます。特に保守運用をベトナムオフショアチームに委託することで、大幅なコスト削減が可能です。

運用体制の構築

システム管理者の育成

社内システム管理者の育成は、持続的な運用体制の確立に不可欠です。計画的な研修プログラムの実施と、実務を通じたスキル向上により、効果的な人材育成が可能になります。

ヘルプデスク体制の確立

ユーザーからの問い合わせに迅速に対応できるヘルプデスク体制の確立が重要です。FAQの整備やチャットボットの活用により、効率的なサポート体制を構築することができます。

ユーザートレーニングプログラム

階層別トレーニング設計

管理者向け、一般ユーザー向け、部門別など、役割や業務内容に応じた最適なトレーニングプログラムを設計します。特に現場のキーユーザーの育成に重点を置くことで、部門内でのサポート体制を確立できます。

オンライン学習環境の整備

ビデオ教材やeラーニングコンテンツを活用することで、時間や場所に縛られない学習環境を提供できます。特に新入社員や異動者向けの自己学習プログラムとして効果を発揮します。

まとめ

キントーンは、業務改善とデジタルトランスフォーメーションを実現する強力なプラットフォームです。

特にベトナムオフショア開発を活用することで、開発コストを40から60パーセント削減しながら、高品質なカスタマイズを実現できます。導入企業の実績から、業務効率の向上と競争力の強化が期待できることが明らかになっています。

キントーンの導入やカスタマイズについて、より詳しい情報や具体的なご相談は、豊富な実績を持つベトナムオフショア開発 Mattockにお気軽にお問い合わせください。

経験豊富なコンサルタントが、貴社の課題解決に最適なソリューションをご提案いたします。

キントーン導入・活用関連

-『【保存版】キントーンのAPIカスタマイズ完全ガイド』 具体的なコード例とベストプラクティスを詳しく解説しています。

-『中小企業のDX成功事例20選』 キントーンを活用した業務改革の具体例を紹介しています。

ベトナムオフショア開発関連

-『ベトナムオフショア開発の費用対効果を徹底検証』 具体的な費用試算と、コスト削減のポイントを解説しています。

-『失敗しないベトナムオフショア開発パートナーの選び方』 信頼できるパートナー選定の重要ポイントを紹介しています。