サイバーセキュリティの最前線において、フィッシング攻撃対策の重要性は年々高まっています。2023年の統計によると、世界における企業のセキュリティインシデントの約37%がフィッシング攻撃に起因しており、その被害額は年間1兆円を超えると推計されています。

本記事では、最新のフィッシング対策システムの設計から実装、運用に至るまでの包括的な知識と実践的なノウハウをお伝えします。

この記事で分かること

- 最新のフィッシング対策システム設計手法と実装のベストプラクティス

- AIと機械学習を活用した高精度URL分析と検知の方法論

- 実践的な防御機能の実装手順と効果的な運用体制の構築方法

- 実際の導入事例と具体的な成功要因の分析

- グローバル展開における法規制対応と地域別の考慮点

この記事を読んでほしい人

- セキュリティシステムの開発責任者とエンジニア

- フィッシング対策の設計・実装を検討している技術者

- セキュリティ運用チームのリーダーと実務担当者

- 既存の対策システムの強化を検討している管理者

- グローバルセキュリティ体制の構築を担当する方々

フィッシング対策システムの基本設計

フィッシング対策システムを効果的に構築するためには、包括的な設計アプローチと最新の技術動向の理解が不可欠です。

本セクションでは、2024年の脅威動向を踏まえながら、システム設計の基本的な考え方から具体的な実装方針まで、実践的な知識を段階的に解説します。特に重要となるリアルタイム検知、インテリジェンス連携、そして自動防御の観点から、効果的なシステム設計の方法論をお伝えします。

最新のフィッシング攻撃手法と対策の概要

サイバーセキュリティの最前線において、フィッシング攻撃の手法は日々進化を続けています。

2024年に入り、特にAIを活用した高度な攻撃手法の増加が顕著となっており、従来の対策では十分な防御が困難になってきています。これらの新しい脅威に対応するため、システム設計の基本的なアプローチも進化が求められています。統計によると、2023年には世界で約37%の組織がフィッシング攻撃による被害を報告しており、その被害額は年間1兆円を超えると推計されています。

進化するフィッシング攻撃の特徴と傾向分析

最新のフィッシング攻撃では、ディープフェイク技術を用いた音声フィッシングやQRコードを悪用した新種の手法が確認されています。

特に注目すべき点として、機械学習モデルを活用した自動文章生成による高度な標的型攻撃が増加しています。これらの攻撃では、自然言語処理技術を駆使して、受信者の属性や過去のコミュニケーションパターンを分析し、極めて説得力の高い偽装メールが作成されています。

また、正規のビジネスメールを横取りして会話に介入する、ビジネスメール詐欺(BEC)の手法も、AIによってさらに洗練されています。このような状況において、従来の静的なルールベースの対策やシグネチャベースの検知では、十分な防御効果を得ることが困難になっています。

効果的な対策アプローチの設計指針

現代のフィッシング対策では、複数の防御層を組み合わせた包括的なアプローチが必要不可欠です。特に重要となるのが、リアルタイムの振る舞い分析、機械学習を活用した予測的防御、そしてインテリジェンス情報の動的な活用です。これらの要素を効果的に組み合わせることで、新種の攻撃に対しても柔軟な対応が可能となります。

また、ユーザーの行動分析とリスクベースの認証機能を統合することで、不正アクセスの早期検知と防止を実現することができます。具体的には、アクセスパターンの異常検知、地理的位置情報の分析、デバイスフィンガープリントの照合など、多角的な認証要素を組み合わせることで、セキュリティレベルを向上させることができます。

システム設計の基本方針と実装戦略

フィッシング対策システムの設計では、セキュリティ、パフォーマンス、そして運用効率の適切なバランスを取ることが重要です。特に大規模組織での運用を想定する場合、システムの拡張性と管理性を考慮した設計が不可欠となります。また、コンプライアンス要件への対応も重要な設計要素となります。

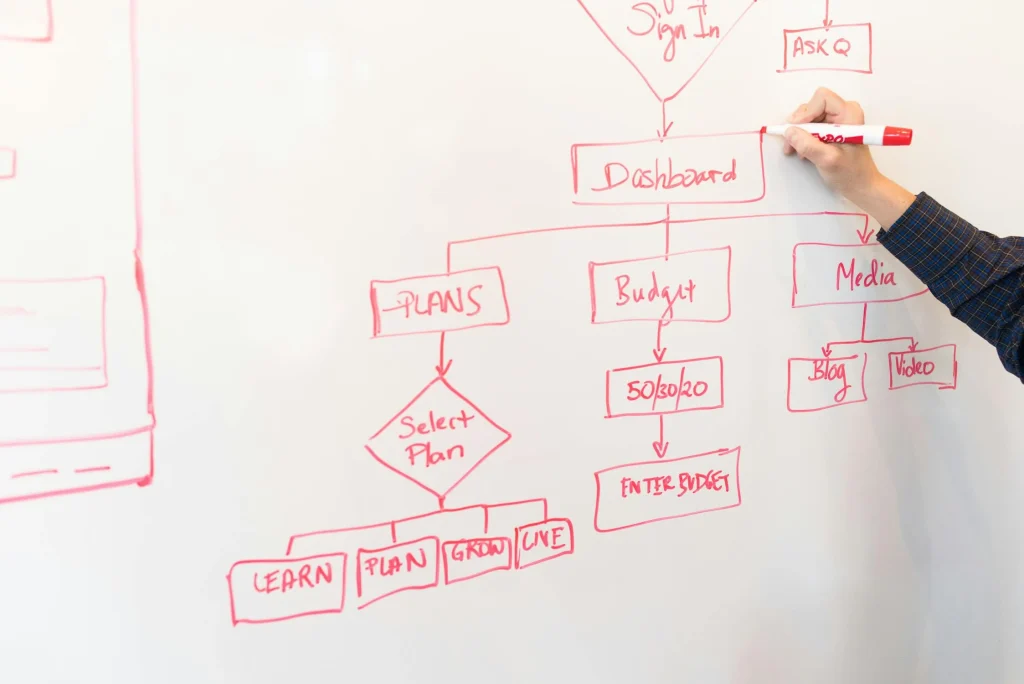

アーキテクチャ設計の重要ポイントと選択基準

システムのアーキテクチャ設計において最も重要なのは、スケーラビリティとメンテナンス性の確保です。特に注目すべき点として、マイクロサービスアーキテクチャの採用があります。各機能をマイクロサービスとして分割することで、システムの柔軟な拡張と更新が可能となります。

具体的には、検知エンジン、URL分析、コンテンツフィルタリング、レポーティングなどの機能を独立したサービスとして実装し、APIを通じて連携させます。

攻撃検知の高度化戦略

フィッシング攻撃の検知精度を向上させるため、高度な検知手法の実装が必要です。特に重要となるのが、機械学習モデルの適切な選定と、効果的な特徴量エンジニアリングです。

機械学習モデルの選定基準

検知システムで利用する機械学習モデルの選定では、以下の要素を考慮します。

まず、モデルの解釈可能性が重要です。なぜその判定が行われたのかを説明できることが、運用面での信頼性向上につながります。次に、リアルタイム処理能力です。オンラインでの高速な推論が可能なモデルアーキテクチャを選択する必要があります。

また、継続的な学習と更新のしやすさも重要な選定基準となります。

特徴量エンジニアリングのベストプラクティス

効果的な特徴量エンジニアリングには、ドメイン知識とデータサイエンスの両方の視点が必要です。URLの構造解析、メールヘッダーの分析、コンテンツの言語学的特徴など、多角的な特徴量を設計します。また、特徴量の生成過程を自動化し、新しい攻撃パターンにも柔軟に対応できる仕組みを構築します。

システム統合とAPI設計

フィッシング対策システムの各コンポーネントを効果的に連携させるため、適切なAPI設計が重要です。RESTful APIの設計原則に従いながら、システム全体の整合性と拡張性を確保します。

RESTful APIの設計方針

APIの設計では、リソース指向のアーキテクチャを採用し、明確なエンドポイント構造を定義します。バージョニング、認証・認可、レート制限など、APIの運用に必要な機能も適切に実装します。また、API仕様をOpenAPI(Swagger)で文書化し、開発者の利便性を向上させます。

エラーハンドリングの実装

API連携におけるエラーハンドリングでは、適切なステータスコードとエラーメッセージの設計が重要です。システムの状態を正確に伝えながら、必要な情報のみを開示するセキュアな実装を心がけます。また、障害時の代替フローやフォールバック機能も実装し、システムの耐障害性を向上させます。

評価指標とモニタリング体制

フィッシング対策システムの効果を継続的に評価し、改善につなげるためには、適切な評価指標の設定と監視体制の整備が重要です。定量的な指標に基づくPDCAサイクルを確立し、システムの継続的な改善を図ります。

パフォーマンス指標の設定と分析

システムのパフォーマンスを評価するため、複数の指標を設定し、継続的にモニタリングします。検知率、誤検知率、応答時間などの基本指標に加え、ユーザー影響度やビジネス影響度なども評価します。これらの指標を総合的に分析することで、システムの改善点を特定し、効果的な対策を講じることができます。

モニタリングシステムの実装

システムの状態を継続的に監視するため、包括的なモニタリングシステムを実装します。インフラストラクチャのメトリクス、アプリケーションログ、セキュリティイベントなど、多層的なモニタリングにより、問題の早期発見と迅速な対応を可能にします。また、アラートの設定とエスカレーションルートを明確化し、インシデント発生時の迅速な対応を確保します。

実装フェーズの詳細

フィッシング対策システムの実装フェーズでは、設計段階で定義した要件を実際のシステムとして具現化していきます。

本セクションでは、データベース設計からURL分析エンジンの実装、検知システムの構築、そして防御機能の実装まで、具体的な実装手法と注意点を解説していきます。特に重要となるパフォーマンス、スケーラビリティ、そして保守性の観点から、実装における各要素の詳細と最適な組み合わせ方を説明していきます。

データベース設計と最適化

フィッシング対策システムの中核を担うデータベース設計では、大量のデータを効率的に処理しながら、高速なクエリ応答を実現する必要があります。システムの性能と拡張性を確保するため、適切なデータモデリングとインデックス設計が重要となります。また、24時間365日の継続的な運用を支えるため、堅牢なバックアップ体制と復旧戦略の確立も不可欠です。

スキーマ設計と性能最適化

データベーススキーマの設計では、フィッシング対策に必要な様々なデータ型に対応する必要があります。URLデータ、ドメイン情報、検知ルール、インシデントログなど、異なる種類のデータを効率的に格納し検索できる構造が求められます。

特に重要となるのが、時系列データの効率的な管理です。インシデントログや検知履歴は時間の経過とともに増加していくため、パーティショニングやシャーディングなどの手法を活用して、データの肥大化に対応する必要があります。

また、地理的分散を考慮したデータレプリケーション戦略も重要です。プライマリサイトとセカンダリサイト間でのデータ同期を確実に行い、災害時でもサービスの継続性を確保します。

バックアップと復旧戦略

データベースのバックアップ戦略では、フルバックアップと差分バックアップを組み合わせた効率的な方式を採用します。特に重要なのが、バックアップデータの整合性確保です。トランザクションログのバックアップを含めた包括的な戦略を立案し、必要な時点への正確なリストアを可能にします。

また、定期的なリストアテストを実施することで、バックアップデータの信頼性を確認します。復旧時間目標(RTO)と復旧ポイント目標(RPO)を明確に定義し、それらを満たすバックアップスケジュールを設計します。

クエリパフォーマンスの最適化戦略

高速なデータアクセスを実現するため、クエリパフォーマンスの最適化は不可欠です。特に、リアルタイム検索とバッチ処理の両方に対応するため、適切なインデックス設計が重要となります。実行頻度の高いクエリに対してはカバリングインデックスを作成し、不要なテーブルアクセスを削減します。

また、クエリの実行計画を定期的に分析し、必要に応じてインデックスの追加や削除を行います。メモリキャッシュの活用も重要で、頻繁にアクセスされるデータセットを特定し、効率的なキャッシュ戦略を実装します。さらに、クエリのチューニングでは、実際の運用データを使用したベンチマークテストを実施し、本番環境での性能を正確に予測します。

パフォーマンスモニタリング体制

データベースのパフォーマンスを継続的に監視するため、包括的なモニタリング体制を構築します。クエリの実行時間、CPU使用率、メモリ使用状況、ディスクI/O、コネクション数など、主要な性能指標を常時監視します。

特に重要なのが、スロークエリの検出と分析です。実行時間の長いクエリを自動的に検出し、改善の余地がないか定期的に検討します。また、負荷の高い時間帯における性能低下を防ぐため、リソースの使用状況を予測し、必要に応じてスケールアップやスケールアウトを計画します。

URL分析エンジンの実装

URL分析は、フィッシング対策における重要な要素の一つです。高度な分析エンジンを実装することで、不正なURLを効率的に検知し、ユーザーを保護することができます。特に重要となるのが、リアルタイム性と精度のバランスです。新しい脅威に対する迅速な対応能力と、誤検知を最小限に抑える正確性の両立が求められます。

特徴量抽出エンジンの構築

URL分析における特徴量抽出では、URLの構造的特徴、ドメインの評価情報、SSLサーバー証明書の状態など、多角的な観点からの分析が必要です。文字列パターンの解析、ドメインエイジの確認、Whois情報の取得など、様々な情報源からデータを収集し、統合的な評価を行います。

特に重要となるのが、新しい脅威に対応するための動的な特徴量生成機能です。攻撃手法の進化に合わせて、新しい特徴量を追加できる拡張性の高い設計が求められます。また、特徴量の重要度評価を定期的に実施し、検知精度への寄与度が低い特徴量を適切に除外することで、処理効率の最適化を図ります。

エラー処理とリカバリー機能

特徴量抽出プロセスでは、外部APIの呼び出しやネットワークアクセスが発生するため、堅牢なエラー処理とリカバリー機能の実装が不可欠です。タイムアウト設定、リトライ処理、フォールバックロジックなど、様々な異常系に対する適切な対応を実装します。

特に重要なのが、一部の特徴量抽出が失敗した場合でも、利用可能な特徴量のみで暫定的な評価を行える柔軟な設計です。

機械学習モデルの統合

URL分析における機械学習モデルの統合では、特徴量エンジニアリングと学習アルゴリズムの選択が重要となります。教師あり学習と教師なし学習を組み合わせることで、既知の脅威と未知の脅威の両方に対応することができます。

また、オンライン学習機能を実装することで、新しい脅威パターンに対する適応能力を向上させることができます。モデルの定期的な再学習と評価を通じて、検知精度の継続的な改善を図ります。特に注意が必要なのが、学習データのバランス調整です。フィッシングURLと正常URLの比率を適切に設定し、モデルの汎化性能を確保します。

モデル評価とバージョン管理

機械学習モデルの品質を維持するため、包括的な評価体制と効率的なバージョン管理システムを構築します。評価指標として、適合率、再現率、F1スコアなどを使用し、定期的にモデルの性能を測定します。

また、A/Bテストの仕組みを実装し、新しいモデルの有効性を実環境で検証してから本番環境に展開します。モデルのバージョン管理では、学習データセット、ハイパーパラメータ、評価結果などの関連情報を一元管理し、必要に応じて過去のバージョンへのロールバックを可能にします。

検知システムの実装

フィッシング検知システムの実装では、リアルタイム性と精度の両立が求められます。効率的なデータ処理パイプラインと柔軟な検知ルールの管理が重要となります。また、システムの可用性を確保するため、分散アーキテクチャの採用と適切な冗長化設計が必要です。

リアルタイム検知エンジンの構築

リアルタイム検知エンジンでは、入力データの前処理から検知結果の出力まで、一連の処理を効率的に実行する必要があります。ストリーム処理アーキテクチャを採用することで、大量のデータをリアルタイムに処理することができます。

特に重要となるのが、イベント処理の順序制御とデータの一貫性確保です。タイムスタンプベースのウィンドウ処理や、ウォーターマーク機能を活用して、データの到着遅延に対応します。また、処理の並列度を動的に調整できる機能を実装し、負荷の変動に応じて適切にリソースを割り当てます。

防御機能の実装

フィッシング対策システムの防御機能では、検知結果に基づいて適切なアクションを実行する必要があります。自動化された防御メカニズムと、運用者による手動介入のバランスが重要となります。特に注意が必要なのが、誤検知による正常な通信の遮断を防ぐための制御機能です。

インシデント対応の自動化

インシデント対応の自動化では、検知からアクション実行までの一連のワークフローを効率的に処理する必要があります。重要度に基づく優先度付けと、適切なエスカレーションルートの設定により、効果的なインシデント管理を実現することができます。

また、SOCツールとの連携機能を実装することで、セキュリティ運用との統合を図ることができます。運用効率を向上させるため、インシデントの自動分類や、類似事例の検索機能も実装します。

運用体制とプロセス

フィッシング対策システムの効果を最大限に発揮するためには、適切な運用体制の構築と効率的なプロセスの確立が不可欠です。

本セクションでは、24時間365日の監視体制の構築から、インシデント対応プロセス、そして継続的な改善活動まで、実践的な運用方法について解説します。特に重要となる組織体制の整備とプロセスの標準化について、具体的な実装方法をお伝えします。また、運用品質の向上と効率化を実現するための具体的な施策についても詳しく説明していきます。

運用体制の構築と最適化

フィッシング対策の運用体制では、技術チームと運用チームの緊密な連携が必要です。また、経営層との円滑なコミュニケーションチャネルを確保し、迅速な意思決定を可能にする体制作りが重要となります。運用の効率化と品質向上を両立させるため、体制の継続的な最適化も必要です。

特に重要となるのが、各チームの役割と責任の明確化、そして効果的なコミュニケーション経路の確立です。

チーム構成と役割分担

運用チームの構成では、技術スキルとビジネス知識のバランスが重要となります。フィッシング対策の専門家、システムエンジニア、セキュリティアナリスト、そして運用管理者など、異なる専門性を持つメンバーを適切に配置します。特に重要なのが、シフト制による24時間監視体制の確立です。チームメンバーの負荷を考慮しながら、適切なローテーションを組む必要があります。

また、突発的なインシデント対応に備えて、オンコール体制も整備します。各シフトには必要なスキルセットを持つメンバーを確実に配置し、シフト間での円滑な引き継ぎを可能にします。

スキル育成とナレッジ管理

運用チームのスキル向上は、システムの効果的な運用に直結します。定期的なトレーニングプログラムを実施し、最新のフィッシング手法や対策技術に関する知識を共有します。

特に重要なのが、実際のインシデント対応経験をナレッジベース化することです。過去の対応事例を分析し、ベストプラクティスとして文書化することで、チーム全体のスキル向上につなげます。また、新しい攻撃手法や対策技術に関する情報を定期的にアップデートし、チームの技術力を最新に保ちます。

コミュニケーション体制の整備

効果的な運用には、チーム内外のコミュニケーションが不可欠です。定例ミーティングやレポーティングの仕組みを確立し、情報共有を促進します。特に重要なのが、インシデント発生時の緊急連絡体制です。エスカレーションルートを明確化し、関係者への迅速な情報伝達を可能にします。

また、他部門やベンダーとの連携も重要で、明確なコミュニケーションチャネルを確保します。定期的なステークホルダーミーティングを実施し、システムの運用状況や課題について共有することで、組織全体での理解と協力を得ることができます。

モニタリングプロセスの確立

システムの稼働状況と検知精度を継続的に監視するため、包括的なモニタリングプロセスを確立します。リアルタイムモニタリングと定期的な分析を組み合わせることで、システムの健全性を維持します。特に重要なのが、異常検知の精度向上と、効率的なアラート管理です。

監視項目と基準値の設定

システム監視では、性能指標とセキュリティ指標の両面からモニタリングを行います。CPU使用率、メモリ使用量、ディスクI/Oなどの基本的な性能指標に加え、検知率や誤検知率などのセキュリティ指標も重要です。それぞれの指標について適切な基準値を設定し、閾値超過時のアラート発報条件を定義します。

また、定期的に基準値の見直しを行い、システムの成長に合わせて調整します。監視データは長期的なトレンド分析にも活用し、システムの改善計画に反映させます。

アラート管理とエスカレーション

アラートの管理では、重要度に応じた適切な優先順位付けが必要です。緊急度の高いアラートは即座に対応が必要ですが、警告レベルのアラートは定期的なレビューで対応を検討します。エスカレーションルールを明確に定義し、必要に応じて上位者や関連部門への報告を行います。

また、アラートの発生履歴を分析し、システムの改善につなげます。特に重要なのが、誤検知の削減とアラートの最適化です。定期的にアラートルールを見直し、実効性の高い監視体制を維持します。

インシデント対応プロセス

フィッシング攻撃を検知した際の対応プロセスを標準化し、迅速かつ適切な対応を可能にします。初動対応から収束判断まで、一連の流れを明確化することで、効率的なインシデント管理を実現します。特に重要なのが、対応手順の文書化と、定期的な訓練の実施です。

インシデント分類と優先度判定

検知されたインシデントを適切に分類し、対応の優先順位を決定します。影響範囲、重要度、緊急度などの要素を考慮し、体系的な判断基準を設定します。特に、ビジネスクリティカルなシステムに関連するインシデントは、最優先で対応する必要があります。また、インシデントの種類に応じた対応テンプレートを用意し、効率的な対応を可能にします。

対応手順の実行管理

標準化された対応手順に従い、必要なアクションを確実に実行します。対応状況を記録し、後の分析に活用できるよう文書化することも重要です。また、対応完了後は、実施した対策の有効性を評価し、必要に応じて追加の対策を検討します。特に重要なのが、インシデントからの学習です。各インシデントの詳細な分析結果を、システムの改善や運用プロセスの最適化に活用します。

継続的改善活動の実践

システムの効果を維持向上させるため、継続的な改善活動を実施します。定期的な評価と分析を通じて、運用プロセスの最適化とシステムの強化を図ります。PDCAサイクルを確実に回し、改善の効果を定量的に測定することが重要です。

パフォーマンス分析と改善計画

システムのパフォーマンスを定期的に分析し、改善点を特定します。検知精度やレスポンス時間など、主要な指標の推移を追跡し、必要な対策を講じます。また、運用効率の観点からも分析を行い、作業の自動化や省力化を推進します。改善計画は優先度を付けて管理し、計画的な実施を心がけます。

運用品質の向上施策

運用品質を継続的に向上させるため、定期的な運用レビューを実施します。インシデント対応の振り返りや、ヒヤリハット事例の共有を通じて、運用プロセスの改善につなげます。また、ユーザーからのフィードバックも重要な改善の機会として活用します。運用品質の指標を設定し、定期的に測定することで、改善の効果を可視化します。

グローバル展開における考慮点

フィッシング対策システムをグローバルに展開する際には、各地域特有の法規制への対応や、言語・文化の違いを考慮した実装が必要となります。本セクションでは、グローバル展開において考慮すべき重要なポイントと、効果的な対応方法について解説します。特に、データ保護規制への準拠、多言語対応、そして地域ごとの脅威特性への対応方法を詳しく説明します。

地域別の法規制対応とコンプライアンス

グローバル展開において最も重要となるのが、各地域の法規制への適切な対応です。特にデータ保護やプライバシーに関する規制は地域によって大きく異なり、慎重な対応が必要となります。システムの設計段階から、これらの規制要件を考慮に入れることが重要です。

EUにおけるGDPR対応の詳細

EUでのサービス展開では、GDPRへの準拠が必須となります。特に重要なのが、個人データの処理に関する同意取得と、データの越境移転に関する規制への対応です。フィッシング対策システムでは、メールアドレスやURLなどの個人データを扱うため、適切なデータ処理の仕組みを実装する必要があります。

また、データの保持期間の設定や、削除要求への対応機能も重要となります。さらに、データ保護影響評価(DPIA)の実施と、記録の保持も必要です。

アジア太平洋地域の規制対応

アジア太平洋地域では、各国独自のデータ保護法に対応する必要があります。日本の個人情報保護法、中国のサイバーセキュリティ法、シンガポールのPDPAなど、国ごとに異なる要件に適切に対応することが求められます。

特に重要なのが、データの域内保存要件への対応です。中国では特に厳格なデータローカライゼーション要件があり、専用のインフラストラクチャの構築が必要となる場合もあります。

多言語対応システムの構築

グローバルサービスとして効果的に機能させるためには、包括的な多言語対応が不可欠です。単なる画面表示の翻訳だけでなく、フィッシング検知ロジックにも言語特有の考慮が必要となります。

検知エンジンの言語別最適化

フィッシング検知エンジンでは、各言語特有の文字セットやフレーズパターンに対応する必要があります。特に重要なのが、非ラテン文字を使用する言語への対応です。中国語、日本語、アラビア語などでは、文字エンコーディングやテキスト分析の手法を適切に調整する必要があります。

また、言語固有のフィッシングパターンを学習データに反映し、検知精度を向上させることも重要です。

多言語コンテンツ管理システム

警告メッセージや通知内容の多言語化には、効率的なコンテンツ管理システムが必要です。翻訳ワークフローを自動化し、各言語版の同期を維持する仕組みが重要となります。また、地域ごとのブランドガイドラインや文化的な配慮も必要です。

グローバルインシデント対応体制

24時間365日の監視体制を実現するため、地域をまたいだSOC(Security Operation Center)の構築が重要です。時差を活用したフォロー体制を確立し、継続的な監視と対応を可能にします。

タイムゾーン別の対応フロー

グローバル展開では、異なるタイムゾーンでの運用を効率的に管理する必要があります。各地域のSOCチーム間での円滑な引き継ぎプロセスを確立し、インシデント対応の継続性を確保します。また、緊急時の対応体制として、地域間でのバックアップ体制も整備します。

インシデント情報の共有と活用

各地域で検知された脅威情報を効果的に共有し、グローバルな防御能力を向上させることが重要です。共通のインシデント管理プラットフォームを導入し、リアルタイムでの情報共有を実現します。また、定期的なグローバル会議を通じて、各地域の知見や課題を共有します。

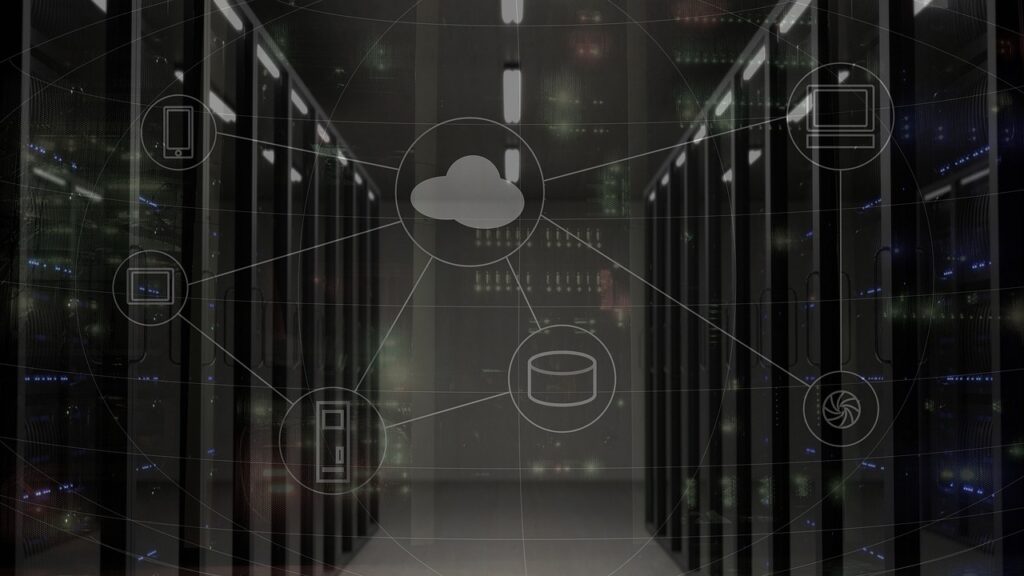

性能最適化とインフラ構成

グローバル展開では、地理的な分散に伴うレイテンシの課題に対応する必要があります。CDNの活用やエッジコンピューティングの導入により、各地域でのパフォーマンスを最適化します。

リージョン別のインフラ構成

各地域の通信特性や規制要件に応じて、適切なインフラ構成を設計します。クラウドサービスのリージョン選択や、オンプレミスインフラの配置を最適化し、高いパフォーマンスと可用性を確保します。また、災害対策の観点から、地域間でのバックアップ体制も整備します。

グローバルロードバランシング

トラフィックの効率的な分散と可用性の確保のため、グローバルロードバランシングを実装します。地理的な位置情報に基づくルーティングや、ヘルスチェックによる自動フェイルオーバーにより、安定したサービス提供を実現します。

運用効率化とコスト最適化

グローバル展開に伴うコストを適切に管理するため、効率的な運用体制と最適なリソース配分が必要です。

リソースの最適配分

各地域の需要と規制要件に応じて、適切なリソース配分を行います。クラウドリソースの動的なスケーリングや、運用チームの適切な配置により、コストパフォーマンスを最適化します。また、定期的なコスト分析を実施し、必要に応じて構成を見直します。

ケーススタディ

フィッシング対策システムの実践的な導入事例から、その効果と課題について学んでいきます。本セクションでは、実在の組織における導入プロジェクトの詳細な分析を通じて、成功要因と失敗から得られた教訓を共有します。これらの事例から、効果的なフィッシング対策システムの構築に向けた具体的な知見を得ることができます。

金融機関Eにおける導入成功事例

大手金融機関Eでは、増加するフィッシング攻撃への対策として、AIを活用した新しい検知システムを導入しました。本事例では、プロジェクトの計画から実装、そして運用に至るまでの過程を詳しく解説します。

プロジェクトの背景と目的

金融機関Eでは、従来のパターンマッチング型の検知システムでは対応が困難な高度なフィッシング攻撃が増加していました。特に問題となっていたのが、正規のビジネスメールを模倣した精巧な攻撃でした。そこで、機械学習を活用した新しい検知システムの導入を決定し、2023年から本格的なプロジェクトを開始しました。

実装アプローチと特徴

新システムの特徴は、自然言語処理技術を活用した高度なコンテンツ分析機能です。メールの文脈を理解し、不自然な表現や通常とは異なるコミュニケーションパターンを検知することで、従来のシステムでは発見が困難だった攻撃を特定することが可能となりました。また、ユーザーの行動分析機能を組み込むことで、不審な操作パターンも検知対象としました。

導入効果と成果

新システムの導入により、フィッシング攻撃の検知率が従来比で35%向上し、誤検知率は60%削減されました。特に効果が高かったのが、なりすましメールの検知です。導入から6か月間で、約200件の高度なフィッシング攻撃を事前に防御することに成功しています。

製造業Fにおける課題克服事例

製造業F社では、グローバル展開に伴うフィッシング対策の強化プロジェクトを実施しました。当初は様々な課題に直面しましたが、段階的なアプローチにより成功を収めた事例です。

直面した課題と対応策

最大の課題は、多言語環境での検知精度の確保でした。特に、アジア圏の言語における特殊文字を使用した攻撃の検知が困難でした。この課題に対し、地域ごとの特徴を学習データに反映させ、検知エンジンをカスタマイズすることで対応しました。また、各地域の法規制に対応するため、データの保存場所とアクセス制御も適切に設計しました。

運用体制の最適化

グローバル展開に伴い、24時間体制での監視が必要となりました。これに対し、地域ごとのSOCを設置し、時差を活用した効率的な運用体制を構築しました。また、インシデント対応の標準化により、地域間での円滑な連携を実現しています。

小売業Gにおける失敗から学ぶ教訓

小売業G社での導入プロジェクトでは、いくつかの重要な課題に直面し、一時的なサービス影響も発生しました。この事例から得られた教訓は、今後のプロジェクトにおいて重要な参考となります。

発生した問題と原因分析

最も深刻だったのが、誤検知による正常なビジネスメールの遮断です。特に、マーケティング部門から送信される大量メールが頻繁にブロックされ、業務に支障をきたしました。原因は、検知ルールの閾値設定が過度に厳格であったこと、そしてホワイトリストの管理が適切でなかったことにありました。

改善策と効果

この問題に対し、段階的なアプローチで改善を図りました。まず、検知ルールの見直しを行い、業務パターンに基づいた適切な閾値を設定しました。また、部門ごとのメール送信パターンを分析し、正常な業務メールの特徴を学習データに反映させました。これらの対策により、誤検知率を大幅に低減しながら、高い検知精度を維持することに成功しています。

事例から得られる重要な示唆

これらのケーススタディから、効果的なフィッシング対策システムの構築には、技術的な実装だけでなく、組織的な取り組みが重要であることが分かります。特に、段階的な導入アプローチ、適切な運用体制の構築、そして継続的な改善プロセスの確立が、プロジェクトの成功に大きく寄与しています。

教えてシステム開発タロウくん!!

フィッシング対策システムの開発や運用に関する実践的な疑問について、経験豊富なシステム開発タロウくんが分かりやすく解説します。現場で実際に直面する技術的な課題から運用上の悩みまで、具体的な解決方法をお伝えします。

機械学習モデルの運用について

Q: 機械学習モデルの更新頻度はどのように決定すればよいですか?

A: 機械学習モデルの更新頻度は、フィッシング攻撃の進化速度と運用リソースのバランスを考慮して決定する必要があります。基本的には月次での定期更新をベースとしつつ、新しい攻撃手法が確認された場合は臨時更新で対応することをお勧めします。

特に重要なのが、検知精度の定期的なモニタリングです。検知率や誤検知率に有意な変化が見られた場合は、すぐにモデルの再学習を検討する必要があります。また、学習データの品質管理も重要で、誤検知事例や見逃し事例を適切にフィードバックすることで、モデルの精度を継続的に向上させることができます。

リアルタイム検知の実装について

Q: 大規模システムでのリアルタイム検知を実現するコツを教えてください。

A: リアルタイム検知の実装では、スケーラビリティとレイテンシの管理が鍵となります。まず重要なのが、検知処理のパイプライン設計です。入力データの前処理、特徴量抽出、モデル推論という一連の流れを、マイクロサービスアーキテクチャで実装することで、各処理の独立したスケーリングが可能になります。

また、キャッシュ戦略も重要です。頻出パターンやドメイン評価結果をキャッシュすることで、処理速度を大幅に向上させることができます。さらに、負荷分散の適切な設定により、システム全体の応答性を確保することが可能です。

インシデント対応の自動化について

Q: インシデント対応の自動化における優先順位の付け方を教えてください。

A: インシデント対応の自動化では、影響範囲と緊急度に基づいた優先順位付けが重要です。まず、組織の重要システムや機密データに関連するインシデントを最優先とします。次に、影響を受けるユーザー数や、攻撃の種類による危険度を考慮します。

自動化システムでは、これらの要素を数値化してスコアリングし、一定のしきい値を超えた場合は即座に対応を開始する仕組みを実装することをお勧めします。また、誤検知のリスクを考慮し、重要度に応じて人による確認ステップを組み込むことも必要です。

運用効率化のポイントについて

Q: 24時間365日の運用を効率的に回すコツを教えてください。

A: 効率的な24時間運用を実現するためには、自動化とチーム体制の最適化が重要です。まず、ルーチン作業の自動化を徹底し、運用担当者は判断が必要な業務に集中できる環境を整えます。

また、シフト制の設計では、負荷の高い時間帯を把握し、適切な人員配置を行うことが大切です。さらに、インシデント対応手順の標準化により、シフト間での円滑な引き継ぎを実現することができます。緊急時のエスカレーションルートを明確化し、オンコール体制も整備することで、突発的な事態にも適切に対応できる体制を構築することができます。

一般的なQ&A

フィッシング対策システムの導入や運用に関して、よくいただくご質問とその回答をまとめました。基本的な疑問から技術的な課題まで、実務に役立つ情報を分かりやすく解説していきます。

システム導入に関する質問

Q: フィッシング対策システムの導入にはどの程度の期間が必要ですか?

A: 導入期間は組織の規模や要件によって異なりますが、一般的な目安として計画フェーズに1~2ヶ月、実装フェーズに2~3ヶ月、テストと調整に1ヶ月程度を見込む必要があります。

特に重要なのが、既存システムとの連携テストと、運用体制の整備です。段階的な導入アプローチを取ることで、リスクを最小限に抑えながら確実な導入を進めることができます。

性能と効果に関する質問

Q: 機械学習を活用した検知システムの精度はどの程度期待できますか?

A: 適切に設計・運用された機械学習ベースの検知システムでは、一般的に90%以上の検知率と、1%未満の誤検知率を実現することが可能です。ただし、これらの数値は継続的なチューニングと、適切な運用体制があってこそ達成できるものです。定期的なモデルの更新と、誤検知事例のフィードバックを適切に行うことが、高い精度を維持するための鍵となります。

コストに関する質問

Q: 運用コストの最適化にはどのような方法がありますか?

A: 運用コストの最適化には、自動化の推進と適切なリソース配分が重要です。特に効果が高いのが、ルーチン作業の自動化と、インシデント対応プロセスの標準化です。また、クラウドサービスを活用することで、インフラコストを需要に応じて柔軟に調整することが可能になります。さらに、運用チームのスキル向上を図ることで、長期的なコスト削減も期待できます。

保守・運用に関する質問

Q: システムの継続的な改善にはどのような取り組みが効果的ですか?

A: 継続的な改善には、定量的な指標に基づくPDCAサイクルの実施が効果的です。検知精度、応答時間、運用効率などの主要指標を定期的に測定し、改善点を特定します。

また、インシデントの分析結果や、ユーザーからのフィードバックも、改善活動の重要な入力となります。改善提案の優先順位付けを適切に行い、計画的に実施することで、システムの価値を継続的に向上させることができます。

まとめ

フィッシング対策システムの構築には、適切な設計、効果的な実装、そして継続的な運用体制の確立が不可欠です。特に重要となるのが、AI・機械学習を活用した検知精度の向上と、グローバル展開を見据えた拡張性の確保です。システムの導入に際しては、組織の特性や要件を十分に考慮し、段階的なアプローチで進めることをお勧めします。

ご相談・お問い合わせ

フィッシング対策システムの開発について、より詳細な相談や具体的な実装に関するご質問がございましたら、Mattockの専門チームにご相談ください。豊富な開発実績を持つベトナムオフショアチームが、お客様の要件に合わせた最適なソリューションをご提案いたします。

下記のフォームからお気軽にお問い合わせください: [ベトナムオフショア開発 Mattock]

また、フィッシング対策システムの開発に関する無料相談も受け付けております。貴社の課題やご要望をお聞かせください。

参考文献

- OWASP, “Phishing Prevention Cheat Sheet 2024”

- 情報処理推進機構(IPA), “フィッシング対策ガイドライン2024年版”

- NIST Special Publication 800-177 Rev. 1

- JPCERT/CC, “フィッシング対策技術実装ガイド2024”

- Microsoft Security Blog, “AI-Powered Phishing Detection Best Practices 2024”

関連記事

- 【ベトナムオフショア開発】最新セキュリティシステムの構築事例

- 【システム開発】AIを活用したセキュリティ対策の実装方法

- 【開発実績】グローバル展開を見据えたシステム設計のポイント

- 【技術解説】機械学習を活用したセキュリティシステムの構築手順