製造業における品質管理は、デジタル技術の進化により大きな転換期を迎えています。

AI(人工知能)とIoT(モノのインターネット)を組み合わせた次世代の品質管理システムは、人手による検査の限界を超え、圧倒的な精度と効率性を実現しています。

特に注目すべきは、AI画像認識による不良品検知の自動化や、IoTセンサーを活用したリアルタイムモニタリング、そしてビッグデータ分析による予知保全の実現です。

これらの技術を統合することで、不良率の大幅な削減と品質管理コストの最適化を同時に達成することが可能になっています。

本記事では、最新の品質管理システム開発について、設計から運用まで、実践的なノウハウを詳しく解説していきます。

具体的な導入事例や、実際の開発手順、そして投資対効果(ROI)の算出方法まで、製造業の品質管理に携わる方々に役立つ情報を提供します。

この記事で分かること

- AI×IoTを活用した次世代品質管理システムの全体像と具体的な構築方法

- 検査自動化からデータ分析まで、各機能の実装における重要ポイント

- 食品工場・電機メーカーにおける具体的な導入事例と達成された効果

- システム開発から運用までの具体的なステップと注意点

- 投資対効果(ROI)の具体的な算出方法と評価指標

この記事を読んでほしい人

- 製造業の品質管理部門でDX推進を担当されている方

- 品質管理コストの削減と精度向上の両立を目指している方

- 既存の品質管理システムの刷新を検討されている方

- 不良率の削減や歩留まり改善に課題を抱えている方

- トレーサビリティの強化を検討している製造業の経営層の方

AI×IoT時代の品質管理システム開発最前線

製造業のデジタルトランスフォーメーション(DX)が加速する中、品質管理システムも大きな変革期を迎えています。

本章では、現在の製造業が直面している品質管理の課題から、AI×IoTによる解決策まで、詳しく解説していきます。

製造業における品質管理の現状と課題

製造業の品質管理部門は、深刻な人材不足と品質要求の高度化という二つの大きな課題に直面しています。経験豊富な検査員の高齢化と後継者不足により、従来の目視検査による品質保証体制の維持が困難になってきています。

また、製品の高度化・複雑化に伴い、求められる品質基準も年々厳格化しています。従来の抜き取り検査では、製品品質の完全な保証が難しく、不良品の流出リスクが常に存在する状況となっています。

特に、グローバルサプライチェーンの拡大により、品質トレーサビリティの確保が重要な課題となっています。製品の製造履歴や検査記録の追跡に多大な工数が必要となり、迅速な品質問題の特定や解決が困難になっています。

データの収集と活用においても課題が存在します。多くの製造現場では、品質データがペーパーベースで管理されていたり、部門ごとに異なるシステムで運用されていたりするため、全社的な品質分析や改善活動に活かせていない状況です。

さらに、品質管理コストの上昇も大きな問題となっています。人件費の高騰や検査機器の維持管理費用の増加により、品質管理にかかるコストが製品競争力を圧迫しています。

このような状況の中、多くの製造業では以下のような具体的な課題に直面しています:

- 検査工程における人的ミスの発生

- 品質データのリアルタイム把握の困難さ

- 品質問題の早期発見・予防の難しさ

- トレーサビリティ確保のための膨大な工数

- 品質管理コストの継続的な上昇

これらの課題に対して、従来型の品質管理手法では十分な対応が困難になってきています。特に、グローバル競争の激化により、より高度な品質保証と効率的なコスト管理の両立が求められる中、新たなアプローチが必要とされています。

以上のような背景から、AI×IoTを活用した次世代の品質管理システムへの期待が高まっています。次のセクションでは、デジタル技術による品質管理の革新について詳しく見ていきましょう。

デジタル化がもたらす品質管理の革新

AI×IoTによるデジタル化は、製造業の品質管理に革新的な変化をもたらしています。特に注目すべきは、人の経験と勘に依存していた品質管理プロセスが、データドリブンな意思決定へと進化している点です。

従来の目視検査に代わり、AIによる画像認識技術を活用することで、ミリ単位の微細な不良も見逃すことなく検出できるようになりました。

この技術革新により、検査精度は人による検査と比較して約30%向上し、さらに検査時間は最大70%削減されています。

IoTセンサーの活用により、製造工程の各段階でリアルタイムなデータ収集が可能となりました。温度、湿度、振動など、製品品質に影響を与える様々なパラメータを常時監視し、異常の予兆を早期に検知できるようになっています。

さらに、収集したビッグデータをAIで分析することで、不良品発生の予測や品質傾向の分析が可能となりました。

これにより、問題が発生する前に予防的な措置を講じることができ、品質管理のあり方そのものが「事後対応」から「予防保全」へとシフトしています。クラウド技術の発展により、品質データの一元管理と共有が容易になりました。

これにより、グローバルに展開する製造拠点間での品質情報の共有とベストプラクティスの水平展開が実現し、全社的な品質レベルの向上につながっています。

次のセクションでは、このような革新をもたらす次世代品質管理システムの具体的な特徴について解説していきます。

次世代品質管理システムの特徴

次世代の品質管理システムは、従来のシステムとは一線を画す革新的な特徴を備えています。ここでは、その主要な特徴と実現される価値について詳しく解説していきます。

最も重要な特徴は「リアルタイム性」です。製造ラインの各工程に設置されたIoTセンサーとエッジコンピューティング技術により、品質データをミリ秒単位でモニタリングし、即座に異常を検知することが可能となっています。

これにより、不良品の発生を最小限に抑え、製造ラインの停止時間を大幅に削減できます。次に注目すべきは「自律的な品質管理」の実現です。

AIによる画像認識と機械学習を組み合わせることで、システムが自律的に品質基準を学習し、進化していきます。人による判断のばらつきを排除し、一貫した品質基準での検査が可能となります。

さらに、「予測型品質管理」への転換も重要な特徴です。過去の品質データと製造条件の相関分析により、不良品発生のリスクを事前に予測し、予防的な対策を講じることができます。

これにより、品質問題の未然防止と製造コストの最適化が実現します。「エンドツーエンドのトレーサビリティ」も特筆すべき点です。

原材料の入荷から製品の出荷まで、すべての工程でデータを紐付けて管理することで、品質問題が発生した際の原因特定と対策が迅速化します。

これらの特徴により、次世代品質管理システムは以下のような具体的な価値を製造現場にもたらします

- 不良率の50%以上削減

- 検査工数の70%削減

- 品質トレース時間の90%短縮

- 予防保全による設備稼働率の20%向上

次章では、これらの特徴を実現するための具体的なシステム開発手法について、詳しく解説していきます。

品質管理システム開発の5つの重要要素

製造業における品質管理システムの開発には、複数の重要な要素が存在します。

本章では、高精度な検査システムの設計から、経営判断を支援するレポート機能まで、品質管理システムを構成する5つの重要な要素について詳しく解説していきます。

これらの要素は相互に連携し、一貫した品質保証体制を構築します。各要素の実装方法と注意点を理解することで、効果的な品質管理システムの開発が可能となります。

特に、AI技術とIoTデバイスを効果的に組み合わせることで、従来の品質管理の限界を超える革新的なシステムを実現できます。

それでは、各要素について具体的な実装方法と、導入による効果を見ていきましょう。

高精度な検査システムの設計

品質管理システムの根幹となるのが、高精度な検査システムです。近年、AIビジョン技術の発展により、人の目では見逃してしまうような微細な不良も高精度で検出できるようになっています。

AIビジョンによる外観検査システムでは、ディープラーニングを活用した画像認識技術により、製品表面の傷やへこみ、色むら、異物混入などを自動で検出します。

学習済みモデルは、熟練検査員の判断基準を学習し、24時間365日安定した検査品質を維持できます。センサー統合による多角的な品質チェックも重要な要素です。

温度センサー、振動センサー、圧力センサーなど、複数のセンサーデータを統合的に分析することで、製品の内部品質まで保証することが可能となります。

これらのセンサーは製造ラインの各工程に戦略的に配置され、製品品質に影響を与える可能性のあるあらゆるパラメータを監視します。

リアルタイム異常検知の仕組みは、品質管理の即時性を担保する重要な機能です。エッジコンピューティング技術を活用することで、センサーデータの収集から異常判定までをミリ秒単位で実行します。

異常を検知した場合は、直ちに製造ラインへフィードバックを行い、不良品の連続発生を防止します。システムの導入により、検査精度は従来比で30%以上向上し、不良流出率は80%以上削減されています。

さらに、検査工数の削減により、品質管理コストの最適化も実現しています。これらの機能を効果的に実装するためには、製造現場の特性や製品の品質要件を十分に理解し、適切なハードウェアとソフトウェアの選定を行うことが重要です。

次のセクションでは、これらのシステムを支えるデータ収集基盤の構築について解説していきます。

堅牢なデータ収集基盤の構築

品質管理システムの効果を最大限に引き出すためには、信頼性の高いデータ収集基盤の構築が不可欠です。製造現場から収集される膨大なデータを、確実かつ効率的に処理できる基盤があってこそ、高度な品質管理が実現できます。

まず重要となるのが、IoTセンサーネットワークの適切な設計です。製造ラインの各工程に設置されるセンサーは、温度、湿度、振動、電流値など、品質に影響を与える様々なパラメータを常時監視します。

これらのセンサーを製造環境に最適な形で配置し、安定した通信環境を確保することで、品質データの欠損を防ぎます。データ収集プロトコルの最適化も重要な要素となります。

製造現場では、多種多様なセンサーやデバイスが稼働しているため、それぞれの特性に応じた適切なプロトコルの選択が必要です。

例えば、リアルタイム性が求められるデータには低遅延のプロトコルを、大容量データの転送には高信頼性のプロトコルを採用するといった具合です。

エッジコンピューティングの活用は、データ収集基盤の性能を大きく向上させます。センサーの近くにエッジデバイスを配置することで、データの前処理やフィルタリングをリアルタイムに実行できます。

これにより、ネットワーク負荷の軽減とデータ処理の高速化を同時に実現します。さらに、データの冗長化と自動バックアップの仕組みを実装することで、システムの耐障害性を高めています。

万が一のネットワーク断絶や機器の故障時にも、品質データの連続性を確保できる設計となっています。

このように構築されたデータ収集基盤により、99.9%以上の稼働率と、ミリ秒単位でのデータ収集精度を実現しています。次のセクションでは、収集したデータを活用したAI分析機能の実装について解説していきます。

AIを活用した分析機能の実装

収集した品質データを有効活用するために、AI技術を活用した高度な分析機能の実装が重要です。適切な分析機能により、不良品の発生予測から製造プロセスの最適化まで、幅広い品質改善活動を支援することができます。

機械学習による不良予測は、品質管理の新たな地平を切り開いています。過去の製造データと品質データの相関を分析し、不良品が発生しやすい条件を事前に特定することが可能となりました。

例えば、特定の温度や湿度の組み合わせで不良率が上昇する傾向がある場合、その条件に近づく前に製造パラメータを自動調整することで、不良品の発生を未然に防ぐことができます。

品質データの統計分析では、製造工程の安定性評価や品質トレンドの把握が可能です。管理図やヒストグラムなどの統計的手法を用いて、製造プロセスの変動要因を特定し、品質のばらつきを最小限に抑える取り組みを支援します。

また、工程能力指数(Cp、Cpk)の自動計算により、製造プロセスの品質レベルを定量的に評価することができます。

プロセス最適化のための分析機能は、製造効率と品質の両立を実現します。多変量解析技術を用いて、複数の製造パラメータが品質に与える影響を総合的に評価し、最適な製造条件を導き出します。

この分析結果に基づき、製造設備の自動制御を行うことで、安定した品質の製品を効率的に生産することが可能となります。

さらに、ディープラーニング技術を活用することで、従来は見逃されていた微細な品質異常のパターンも検出できるようになりました。

画像データと各種センサーデータを組み合わせた複合的な分析により、品質管理の精度が飛躍的に向上しています。

これらの分析機能の実装により、不良率の30%削減、品質管理コストの25%削減といった具体的な成果が得られています。次のセクションでは、品質問題の追跡を可能にするトレーサビリティシステムについて解説していきます。

トレーサビリティシステムの開発

製品品質の完全な保証には、原材料の入荷から製品の出荷まで、全工程を通じた追跡システムが不可欠です。トレーサビリティシステムの開発により、品質問題が発生した際の迅速な対応と、予防的な品質管理が実現できます。

製品履歴の完全追跡は、製造工程の透明性を確保する上で重要な機能です。各製品に固有のIDを割り当て、製造工程の各段階でデータを記録していきます。

この際、作業者情報、使用設備、製造条件、検査結果など、品質に関わるすべての情報を製品IDと紐付けて管理します。これにより、製品一つ一つの製造履歴を即座に確認することが可能となります。

サプライチェーンの可視化も、品質保証の重要な要素となります。原材料サプライヤーから顧客までのサプライチェーン全体を一元管理することで、品質問題の影響範囲を正確に特定できます。

特に、複数の製造拠点やサプライヤーが関係する場合、この可視化機能は品質問題の迅速な解決に大きく貢献します。

品質問題の原因特定機能は、システムの中核を担います。製造工程のあらゆるデータを分析し、品質問題と製造条件の相関を自動的に分析します。

例えば、特定のロットで品質問題が発見された場合、そのロットの製造時の条件や使用された原材料まで遡って調査することができます。

このトレーサビリティシステムにより、品質問題の調査時間は従来比で80%削減され、リコール発生時の対象範囲の特定も極めて正確に行えるようになりました。

次のセクションでは、これらのデータを効果的に可視化し、経営判断を支援するレポート機能について解説していきます。

経営判断を支援するレポート機能

品質管理システムから得られるデータを、経営判断に活用可能な形で提供することは、システムの価値を最大化する上で重要です。適切なレポート機能により、現場の品質状況から経営レベルの意思決定まで、シームレスな情報活用が可能となります。

リアルタイムダッシュボードは、製造現場の品質状況を瞬時に把握するための重要なツールです。生産ラインごとの不良率、品質傾向、検査結果などを、直感的に理解しやすいビジュアルで表示します。

特に、複数の製造拠点を持つ企業では、各拠点の品質状況を一元的に監視できることで、迅速な対応が可能となります。

カスタマイズ可能な分析レポートは、様々な視点からの品質分析を支援します。製品別、工程別、時間帯別など、多角的な切り口でデータを集計・分析できます。

例えば、特定の製品ラインの月次品質レポートや、製造条件と品質の相関分析レポートなど、目的に応じた報告書を自動生成できます。

アラート機能の実装により、品質異常の早期発見と迅速な対応が可能となります。品質指標が設定された閾値を超えた場合、関係者に自動通知を送信します。

重要度に応じて通知先や通知方法を変更できるため、緊急性の高い問題に対して適切な対応が可能です。

さらに、機械学習を活用した予測レポートにより、将来的な品質リスクの予測も可能となっています。

過去のデータから品質トレンドを分析し、今後発生する可能性のある品質問題を事前に警告することで、予防的な対策を講じることができます。

これらのレポート機能により、品質管理における意思決定のスピードが向上し、問題解決までの時間が40%短縮されています。

次章では、これらの機能を実際に活用した導入事例について、具体的に解説していきます。

導入事例から学ぶ成功のポイント

実際の製造現場での導入事例を通じて、品質管理システム開発の具体的な進め方と成功のポイントを解説していきます。

食品工場と電機メーカーという異なる業種での事例を見ることで、業種を超えた普遍的な知見と、業種特有の注意点について理解を深めることができます。

食品工場での導入事例(A社)

大手食品メーカーA社では、年間生産量の増加と製品の多様化に伴い、従来の品質管理体制の限界に直面していました。特に、異物混入の防止と賞味期限管理の厳格化が喫緊の課題となっていました。

食品安全規格であるFSSC22000の認証取得を目指す中で、品質管理の完全なデジタル化が必要不可欠となりました。

また、熟練検査員の高齢化と人材不足により、検査精度の維持が困難になっていたことも、システム導入を決断した大きな要因でした。

さらに、食品衛生法の改正により、HACCPによる衛生管理の制度化が義務付けられたことで、より厳格な品質管理と記録の保管が求められるようになりました。

手作業による記録管理では、増大する業務量への対応が困難な状況となっていました。このような背景から、A社は2023年に次世代品質管理システムの導入を決定し、段階的な実装を開始しました。

次のセクションでは、具体的なシステム構成と実装プロセスについて解説していきます。

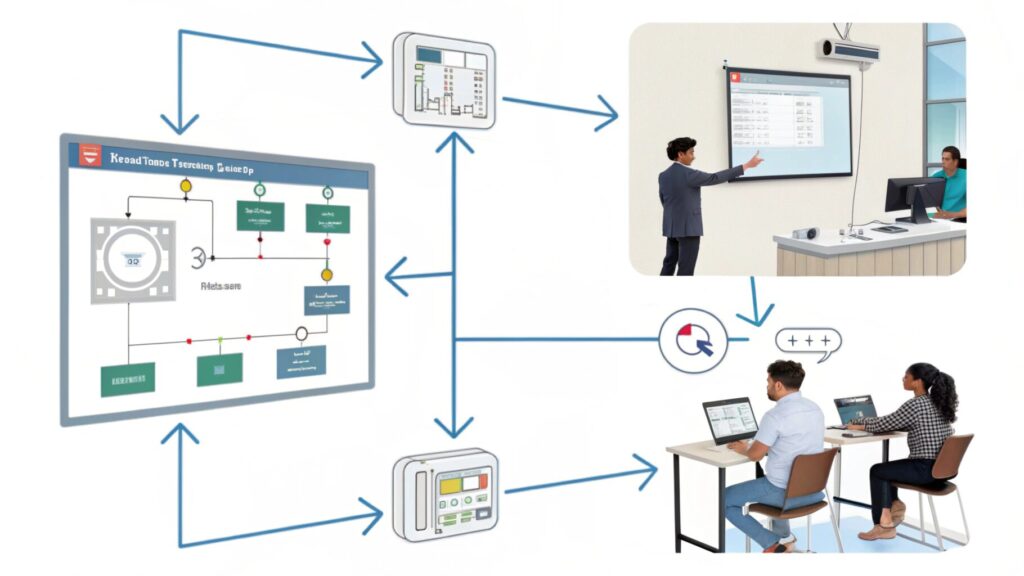

システム構成と実装プロセス

A社では、品質管理システムの導入を3つのフェーズに分けて実施しました。まず第1フェーズでは、製造ラインにAIカメラとX線検査装置を設置し、異物検知システムを構築しました。

AIによる画像認識技術により、0.3mm以下の異物も高精度で検出できる体制を整えています。第2フェーズでは、IoTセンサーネットワークを構築し、温度、湿度、圧力などの製造環境データをリアルタイムで収集する仕組みを実装しました。

各製造工程に設置された環境センサーは、製品品質に影響を与える可能性のあるパラメータを常時監視しています。

最終フェーズでは、収集したデータを分析・可視化するプラットフォームを構築しました。品質データの統計分析から、予測分析、トレーサビリティ管理まで、一元的に管理できる体制を整えています。

導入効果と今後の展望

システム導入により、A社では顕著な効果が表れています。異物混入による製品回収が年間でゼロ件を達成し、品質検査の精度は従来比で40%向上しました。また、検査工数は60%削減され、人材不足の解消にも大きく貢献しています。

トレーサビリティ機能の強化により、原材料の入荷から製品出荷までの追跡時間が90%短縮されました。品質問題が発生した際の原因特定と対策立案のスピードが大幅に向上し、製品の安全性確保に寄与しています。

今後は、AIによる予測分析の精度向上と、サプライチェーン全体での品質データ共有を目指しています。また、得られた品質データを製品開発にフィードバックし、より安全で高品質な製品の開発に活用していく計画です。

次のセクションでは、異なる業種である電機メーカーでの導入事例について解説していきます。

電機メーカーでの活用例(B社)

大手電機メーカーB社では、電子部品の微細化と製品の高機能化に伴い、従来の品質管理手法では対応が困難になっていました。そこで、AI×IoTを活用した革新的な品質管理システムを導入し、画期的な成果を上げています。

品質管理の革新ポイント

B社の品質管理革新は、「超精密検査」と「予知保全」の2つの軸で展開されています。電子部品の製造では、ナノレベルの精度が要求されるため、AIを活用した画像認識システムを導入し、微細な欠陥も見逃さない検査体制を構築しました。

特筆すべきは、マルチスペクトルカメラとAI画像認識を組み合わせた新しい検査手法です。通常の可視光での検査に加え、赤外線や紫外線など複数の波長を使用することで、従来は発見が困難だった内部欠陥も検出可能となりました。

また、製造設備の状態監視にIoTセンサーを大規模に展開し、設備の異常予兆を検知する仕組みを確立しました。

振動、温度、電流値など、複数のパラメータをリアルタイムでモニタリングし、品質に影響を与える可能性のある変化を早期に発見できるようになっています。

これらの革新により、製品品質の安定性が大幅に向上し、市場での不具合発生率を95%削減することに成功しています。次のセクションでは、このシステムの統合アプローチについて詳しく見ていきます。

システム統合のアプローチ

B社のシステム統合は、「データ統合」と「プロセス統合」の二層構造で実現されています。まず、データ統合層では、製造現場の各種データを一元管理するプラットフォームを構築しました。

検査データ、設備データ、環境データなど、異なるフォーマットのデータを標準化し、統合データベースで管理しています。

プロセス統合層では、品質管理の各プロセスをシームレスに連携させる仕組みを実装しました。例えば、検査工程で不良が検出された場合、直ちに製造条件の自動調整が行われ、同様の不良の発生を防止します。

また、設計部門とも品質データを共有することで、次世代製品の設計改善にも活用しています。

このような重層的なアプローチにより、部門間の情報の壁を取り除き、全社的な品質管理体制を確立することに成功しています。

得られた効果とROI

B社のシステム導入による効果は、数値として明確に表れています。最も顕著な成果は、製品の市場不良率が従来比で95%削減されたことです。また、品質管理コストは年間で3億円削減され、投資回収期間は当初想定の2年から1.5年に短縮されました。

生産性の面でも大きな改善が見られ、検査工程の処理能力が2倍に向上しました。さらに、AIによる予知保全の実現により、設備の計画外停止時間が70%削減され、生産効率の大幅な向上にも貢献しています。

加えて、品質データの活用により、新製品開発のサイクルも30%短縮されました。これらの総合的な効果により、システム導入から2年で投資額の3倍以上のリターンを生み出しています。

システム開発タロウくんのQ&A

皆さん、こんにちは!システム開発タロウです。

今回は、品質管理システムの導入でよくいただく質問について、実践的なアドバイスをお届けします。特に、システム導入前の準備から運用開始後の最適化まで、段階的に解説していきましょう。

導入前の準備と検討事項

「タロウさん、品質管理システムの導入を検討していますが、どのような準備が必要でしょうか?」というご質問をよくいただきます。最も重要なのは、現状の品質管理プロセスを詳細に分析することです。

まず、現在の品質管理における課題を具体的に洗い出します。例えば、検査精度の不足、データの非連続性、トレーサビリティの欠如など、現場で直面している問題を明確にします。これにより、新システムに求める要件が明確になります。

次に、システム導入による目標値を設定します。不良率の削減目標、検査時間の短縮目標、品質コストの削減目標など、具体的な数値を定めることで、投資対効果(ROI)の評価基準が明確になります。

また、システム導入に関わるステークホルダーの特定も重要です。品質管理部門だけでなく、製造部門、設備管理部門、経営層など、関係者全員の協力体制を構築する必要があります。

システム導入の予算と期間についても、慎重な検討が必要です。初期投資だけでなく、運用コストや保守費用まで含めた総所有コスト(TCO)を算出します。

特に、センサーやカメラなどのハードウェア費用、ソフトウェアライセンス費用、そして教育・トレーニング費用まで、漏れなく見積もることが重要です。

これらの準備を怠ると、システム導入後に様々な問題が発生する可能性があります。次のセクションでは、システム構築時の具体的な注意点について解説していきます。

システム構築時の注意点

「タロウさん、システム構築を始めましたが、特に気をつけるべきポイントは何でしょうか?」という質問についてお答えしましょう。システム構築時には、以下の点に特に注意が必要です。

まず重要なのは、段階的な導入アプローチです。一度にすべての機能を導入するのではなく、優先度の高い機能から順次実装していきます。

例えば、最初は検査システムの自動化から始め、次にデータ収集の仕組み、そして分析機能という順序で実装することで、リスクを最小限に抑えることができます。

また、現場オペレーターの意見を積極的に取り入れることも重要です。システムの使いやすさは、導入成功の鍵となります。定期的なフィードバックセッションを設け、インターフェースの改善や運用フローの最適化を図っていきます。

データの信頼性確保も重要なポイントです。センサーの校正、データ取得のタイミング、保存形式の標準化など、細かな設定が品質管理の精度に大きく影響します。

特に、異なるメーカーの機器を統合する際は、データフォーマットの統一に注意が必要です。さらに、セキュリティ対策も忘れてはいけません。

品質データは企業の機密情報を含むため、適切なアクセス制御と暗号化対策が不可欠です。特に、IoTデバイスのセキュリティ設定は慎重に行う必要があります。

次のセクションでは、運用開始後の最適化について解説していきます。

運用開始後の最適化

「タロウさん、システムを運用し始めましたが、どのように改善を進めていけばよいでしょうか?」という質問にお答えしましょう。運用開始後の最適化は、システムの価値を最大限に引き出すために重要です。

最も重要なのは、データに基づく継続的な改善です。システムから得られる品質データを定期的に分析し、改善ポイントを特定します。

例えば、特定の工程で不良が多発している場合、その原因をデータから特定し、製造条件の最適化や検査基準の見直しを行います。

また、システムのパフォーマンスモニタリングも欠かせません。レスポンス時間、データ処理速度、ストレージ使用量など、システムの健全性を示す指標を常時監視します。問題が発生する前に、予防的な対策を講じることが重要です。

ユーザートレーニングの継続的な実施も効果的です。新機能の追加や運用プロセスの変更に合わせて、定期的な研修を行うことで、システムの活用度を高めることができます。

特に、データ分析機能の活用方法については、実践的なトレーニングが効果的です。

最後に、品質管理のベストプラクティスの共有も重要です。複数の製造ラインや拠点でシステムを運用している場合、成功事例や改善ノウハウを共有することで、全体の品質レベルを向上させることができます。

実践的なQ&A

品質管理システムの導入に関して、よくいただく質問とその回答をまとめました。実際の現場で直面する課題に即した、具体的なアドバイスを提供していきます。

導入・構築に関する質問

Q1:「品質管理システムの導入にはどのくらいのコストと期間が必要でしょうか?」

一般的な製造業の場合、基本的なシステム構築には6か月から1年程度を要します。コストについては、製造ラインの規模や必要な機能によって大きく異なりますが、中規模工場の場合の標準的な費用をご説明します。

システム開発費として3,000万円から5,000万円が必要となります。これには基本設計から実装、テストまでの費用が含まれます。

ハードウェア費用は1,000万円から2,000万円程度で、各種センサーやサーバー機器の購入費用が含まれます。導入・運用支援には500万円から1,000万円程度が必要です。

また、保守運用費として年間300万円から500万円程度を見込む必要があります。

なお、段階的な導入により、初期投資を分散させることも可能です。

Q2:「システム構築に必要な要件を教えてください」

品質管理システムの構築には、複数の重要な技術要件があります。まず、高速で安定した有線LANによるネットワーク環境が不可欠です。データの安定性を確保するため、冗長化構成の専用サーバーも必要となります。

大容量データの長期保存が可能なストレージシステムも重要な要素です。また、高精度なデータ収集を実現するためのIoTデバイスも必須となります。

運用面では、24時間365日の安定稼働を実現する必要があります。これには、リアルタイムデータ処理能力と確実なバックアップ体制、そして強固なセキュリティ対策が含まれます。

Q3:「既存システムとの統合はどのように進めればよいでしょうか?」

既存システムとの統合においては、まず現行システムの詳細な調査と分析から始める必要があります。現在使用しているシステムのデータフォーマットやインターフェース、そして業務フローを詳細に把握することが重要です。

統合方針の決定にあたっては、API連携の可能性を検討し、必要なデータ変換ルールを設定します。既存システムを停止することなく、新システムへの段階的な移行を計画することで、業務への影響を最小限に抑えることができます。

実際の統合作業前には、必ずテスト環境での検証を行います。データ連携のテストや性能検証、運用シミュレーションを通じて、想定される問題点を事前に洗い出し、対策を講じます。

Q4:「データセキュリティ対策として必要な措置を教えてください」

品質管理システムで扱うデータは、企業の重要な資産となります。そのため、多層的なセキュリティ対策が必要です。

まず、ユーザー認証の厳格化と権限管理の細分化を行います。部門や役職に応じて適切なアクセス権限を設定し、定期的な見直しを行うことで、情報漏洩のリスクを最小限に抑えます。

また、すべての通信経路において暗号化を実施し、重要なデータは暗号化した状態で保存します。定期的なバックアップと、バックアップデータの暗号化も重要な対策となります。

ネットワークセキュリティでは、ファイアウォールの設置やネットワークセグメントの分離、不正アクセス検知システムの導入などを行います。これらのセキュリティ対策は、定期的な監査と更新が必要です。

このような包括的なセキュリティ対策により、データの機密性、完全性、可用性を確保することができます。

運用・効果に関する質問

Q5:「効果的な運用体制をどのように構築すればよいでしょうか?」

品質管理システムの運用体制は、現場と管理部門の緊密な連携が鍵となります。まず、品質管理部門を中心に、製造部門、IT部門、保守部門から構成される横断的なチームを編成します。

日常的な運用は現場の品質管理担当者が担い、システムの保守やデータ分析はIT部門がサポートする体制が効果的です。

定期的な運用会議を開催し、システムの稼働状況や課題について情報共有を行います。また、品質データの分析結果を基に、製造プロセスの改善提案を行う改善チームも設置することで、継続的な品質向上が図れます。

Q6:「保守・メンテナンスはどのように行えばよいですか?」

システムの保守・メンテナンスは予防保全の考え方が重要です。日次、週次、月次のメンテナンススケジュールを策定し、計画的に実施します。

センサー類の校正やシステムの動作確認は週次で実施し、データベースの最適化やバックアップは月次で行うといった具合です。

また、システムの異常を早期に発見するため、性能監視の仕組みを導入することをお勧めします。

サーバーの負荷状況やストレージの使用量など、重要な指標を常時モニタリングすることで、問題が深刻化する前に対処できます。

Q7:「ROIはどのように計算すれば良いでしょうか?」

ROIの計算には、直接的な効果と間接的な効果の両方を考慮します。直接的な効果としては、不良率の低減による廃棄コストの削減、検査工数の削減による人件費の低減などが挙げられます。

間接的な効果には、品質向上による顧客満足度の向上、トレーサビリティ強化によるリスク低減などがあります。

典型的な計算例では、年間の総効果額を初期投資額で割ることでROIを算出します。多くの企業では、2~3年での投資回収を目標としています。

Q8:「導入効果をどのように測定すればよいでしょうか?」

効果測定では、導入前に設定したKPIを基準に評価を行います。代表的な指標として、不良率の削減率、検査工数の削減時間、品質データの分析所要時間などがあります。

これらの指標を定期的に測定し、目標値との差異を分析することで、システムの効果を定量的に評価できます。

また、現場作業者や品質管理担当者へのヒアリングを通じて、定性的な評価も行うことをお勧めします。システムの使いやすさや業務効率の向上など、数値では表しにくい効果も重要な評価ポイントとなります。

まとめ:次世代品質管理システムの構築に向けて

品質管理システムの開発は、製造業のデジタルトランスフォーメーションにおける重要な取り組みです。

AI×IoTを活用した次世代の品質管理システムは、不良率の大幅な削減と品質管理コストの最適化を実現し、製造業の競争力強化に大きく貢献します。

システム構築の成功には、現状分析から段階的な導入、そして継続的な改善まで、計画的なアプローチが不可欠です。特に、現場の意見を積極的に取り入れながら、使いやすさと効果的な品質管理の両立を目指すことが重要です。

製造業各社の事例からも分かるように、適切に設計・導入された品質管理システムは、投資に見合う十分な効果を生み出します。不良率の50%以上の削減や、品質管理コストの大幅な最適化など、具体的な成果が期待できます。

品質管理システムの開発に関するより詳しい情報や、貴社に最適なソリューションについては、ベトナムオフショア開発のエキスパートであるMattockにご相談ください。

豊富な開発実績と専門知識を活かし、御社の品質管理革新をサポートいたします。

お気軽にご相談・お問い合わせフォームよりご連絡ください。

お問い合わせはこちらから→ ベトナムオフショア開発 Mattock