飲食店情報プラットフォームの開発において、ユーザー体験の向上と効果的な店舗情報管理は開発者が直面する最重要課題です。

本記事では、グルメサイト開発の核となる機能設計から実装まで、実践的な開発手法について解説します。大規模なプラットフォーム開発の経験を持つエンジニアの知見を基に、具体的な実装例とともに、成功のための重要なポイントをお伝えします。

この記事で分かること

- 大規模グルメプラットフォームに必要な主要機能の設計方法と実装手順

- データベース設計からインフラ構築まで、システム全体のアーキテクチャ設計

- レビューシステムの信頼性を高める不正検知と品質管理の実装アプローチ

- 位置情報と連携した高度な検索機能の実現方法とパフォーマンス最適化

- ユーザー行動分析に基づいたレコメンド機能の開発と改善手法

この記事を読んでほしい人

- 新規グルメサイトの開発プロジェクトを担当する開発責任者やプロジェクトマネージャー

- 既存の飲食店情報サービスの改善や機能拡張を検討している開発チーム

- 地域特化型の飲食店情報プラットフォームの立ち上げを計画している事業責任者

- レビューサイトのシステム設計や機能実装に携わるエンジニア

プラットフォームの基本設計

グルメサイトの開発において、基盤となるシステム設計は全体の成功を左右する重要な要素です。ユーザー数の増加に伴うデータ量の増大やアクセス集中に耐えうる設計が必要となります。

本セクションでは、データモデルの設計からインフラストラクチャの構築まで、システム全体のアーキテクチャについて詳しく解説します。

データベース設計

効率的な店舗情報管理を実現するためには、適切なデータモデルの設計が不可欠です。大規模なデータを扱うグルメサイトでは、パフォーマンスとスケーラビリティを考慮したテーブル設計が求められます。

店舗基本情報の管理

店舗基本情報の管理においては、店舗名や住所、電話番号などの基本的な情報に加え、位置情報や営業時間情報など、ユーザーの利便性を高めるための付加的な情報も適切に格納する必要があります。

特に位置情報については、後の検索機能での活用を考慮し、緯度経度情報を正規化した形式で保存することが重要です。また、更新頻度の高い情報と低い情報を適切に分離することで、データベースのパフォーマンスを最適化することができます。

メニュー情報の構造化

メニュー情報の管理では、定期的な価格変更や季節メニューの追加など、頻繁な更新に対応できる柔軟な構造が求められます。メニュー名、価格、説明文に加え、アレルギー情報や写真データの参照情報なども含める必要があります。

また、過去の価格履歴を保持することで、価格変動の分析や適切な価格設定の支援も可能となります。

システムアーキテクチャ

大規模なアクセスに耐えうるスケーラブルなアーキテクチャの構築が必要です。マイクロサービスアーキテクチャを採用することで、機能ごとの独立したスケーリングと保守性の向上を実現します。

マイクロサービスの設計

システムをマイクロサービスとして分割することで、各機能の独立した開発とデプロイメントが可能となります。

例えば、店舗情報管理、レビュー管理、ユーザー管理などの機能を独立したサービスとして実装することで、それぞれの機能に最適な技術スタックの選択や、負荷に応じた個別のスケーリングが可能となります。

キャッシュ戦略

レスポンス時間の改善とデータベース負荷の軽減のため、効果的なキャッシュ戦略の実装が重要です。特に検索結果やよく参照される店舗情報については、分散キャッシュシステムを活用することで、応答時間の短縮とシステム全体の安定性向上を図ることができます。

クラウドインフラの構築

現代のグルメサイト開発においては、クラウドサービスの活用が不可欠です。主要なクラウドプロバイダーが提供する各種サービスを適切に組み合わせることで、高可用性とスケーラビリティを備えたシステムを構築することができます。

コンテナオーケストレーション

コンテナ技術を活用することで、開発環境と本番環境の一貫性を確保し、デプロイメントの効率化を図ることができます。

コンテナオーケストレーションツールを使用することで、サービスの自動スケーリングやローリングアップデートなどの運用面での利点も得られます。

負荷分散設計

複数のリージョンにサービスを展開し、コンテンツ配信ネットワークを活用することで、地理的に分散したユーザーに対して最適なパフォーマンスを提供することができます。また、災害対策の観点からも、マルチリージョン構成は重要な要素となります。

セキュリティ対策

ユーザーデータと店舗情報を保護するため、包括的なセキュリティ対策を実装する必要があります。

認証・認可システム

安全な認証システムの実装により、不正アクセスからシステムを保護します。トークンベースの認証を採用し、適切なアクセス制御を行うことで、セキュアなAPI利用環境を提供することができます。

また、ソーシャルログイン機能の提供により、ユーザーの利便性も向上させることができます。

データ保護

個人情報や決済情報など、機密性の高いデータについては、適切な暗号化処理を施す必要があります。また、定期的なセキュリティ監査を実施することで、新たな脆弱性の早期発見と対策を行うことが重要です。

パフォーマンスモニタリング

システムの安定運用のために、包括的なモニタリング体制の構築が必要です。

メトリクス収集

システムの各種メトリクスを収集し、可視化することで、パフォーマンスの問題や異常を早期に発見することができます。CPU使用率、メモリ使用量、レスポンスタイムなど、重要な指標をリアルタイムで監視することが重要です。

アラート設定

システムの異常を検知した際に、速やかに対応できるよう、適切なアラート設定を行う必要があります。重要度に応じた通知先の設定や、アラートのグルーピングなど、運用チームの負担を考慮した設計が求められます。

レビューシステムの実装

グルメサイトの価値を大きく左右するレビューシステムの構築には、ユーザー投稿の品質管理から不正対策まで、多岐にわたる要素を考慮する必要があります。

本セクションでは、信頼性の高いレビューシステムを実現するための実装手法について詳しく解説します。

評価機能の設計

レビューシステムの中核となる評価機能では、ユーザーが様々な観点から店舗を評価できる仕組みを提供する必要があります。

多角的評価システム

飲食店の評価においては、料理の味やサービス、コストパフォーマンス、雰囲気など、多様な要素を総合的に判断することが重要です。

また、各評価項目に対して5段階評価を採用し、それらの重み付け平均による総合評価を算出することで、より正確な店舗の評価を実現することができます。

評価の信頼性担保

評価の信頼性を高めるため、実際の来店確認や評価の根拠となる具体的なコメントの入力を必須とすることが効果的です。

また、評価履歴や投稿パターンの分析により、信頼性の高いユーザーの評価をより重視するシステムを構築することで、評価の質を向上させることができます。

ユーザーインタラクション

活発なユーザーコミュニティを形成するため、適切なインタラクション機能の実装が重要となります。

エンゲージメント機能

レビューに対する「参考になった」ボタンや、コメント機能の実装により、ユーザー間のコミュニケーションを促進することができます。

また、定期的なレビュアーランキングの発表や、貢献度に応じたバッジの付与など、ユーザーのモチベーション維持につながる機能も効果的です。

ソーシャル連携

SNSとの連携機能を実装することで、レビューの拡散性を高め、プラットフォームの認知度向上につなげることができます。ただし、プライバシーに配慮した適切な共有設定オプションを提供することも重要です。

不正検知システム

レビューの信頼性を維持するため、強固な不正検知システムの実装が不可欠です。

自動検知アルゴリズム

機械学習を活用した不正レビュー検知システムにより、投稿パターンや文章の特徴から不自然なレビューを自動的に検出します。また、IPアドレスや投稿時間帯の分析により、組織的な不正投稿も効率的に検出することができます。

モデレーション体制

自動検知システムと人的チェックを組み合わせたハイブリッドなモデレーション体制を構築することで、より確実な品質管理を実現します。特に、AIによる一次スクリーニングの後、専門のモデレーターによる確認を行うことで、誤検知を最小限に抑えることができます。

画像処理システム

レビューの信頼性と魅力を高める重要な要素として、画像投稿機能の実装があります。

画質最適化処理

投稿された画像に対して、自動的なリサイズや圧縮処理を行うことで、表示速度の最適化とストレージコストの削減を実現します。また、複数の解像度のバリエーションを用意することで、デバイスやネットワーク環境に応じた最適な画像提供が可能となります。

不適切コンテンツの検出

画像認識AIを活用することで、不適切な画像やメニューと関係のない画像を自動的に検出し、フィルタリングすることができます。また、画像内のテキスト情報の抽出により、メニュー情報の自動更新などにも活用することが可能です。

データ分析基盤

レビューデータの分析により、サービスの改善やユーザー満足度の向上につなげることができます。

トレンド分析

時系列でのレビュー傾向の分析により、店舗の評価推移や季節的な変動を把握することができます。また、テキストマイニングによるキーワード分析により、ユーザーの関心事項や改善要望を効率的に抽出することが可能です。

レポーティング機能

店舗オーナー向けに、詳細な分析レポートを提供することで、サービス改善のための有益な情報を提供することができます。競合店舗との比較分析や、時間帯別の評価推移など、多角的な分析データの提供が効果的です。

検索機能の最適化

グルメサイトにおいて、ユーザーが求める店舗を素早く正確に見つけられる検索機能は、サービスの価値を大きく左右する重要な要素です。

本セクションでは、高度な検索アルゴリズムの実装から、パフォーマンスの最適化まで、効果的な検索機能の構築方法について解説します。

検索アルゴリズムの実装

ユーザーの多様な検索ニーズに応えるため、複数の検索手法を組み合わせた総合的な検索システムの構築が必要です。

キーワード検索エンジン

店舗名や料理名、エリア名など、テキストベースでの検索を効率的に処理するため、全文検索エンジンの実装が重要です。形態素解析による日本語検索の最適化や、同義語辞書の活用により、ユーザーの意図に沿った検索結果を提供することができます。

さらに、タイプミスや表記ゆれにも対応できるファジー検索機能の実装により、検索の網羅性を向上させることができます。

条件検索の最適化

予算範囲や営業時間、座席数などの数値的な条件による絞り込み検索を効率的に処理するため、適切なインデックス設計が必要です。複数の条件を組み合わせた検索にも高速に応答できるよう、複合インデックスの活用や検索クエリの最適化を行うことが重要です。

位置情報検索の実装

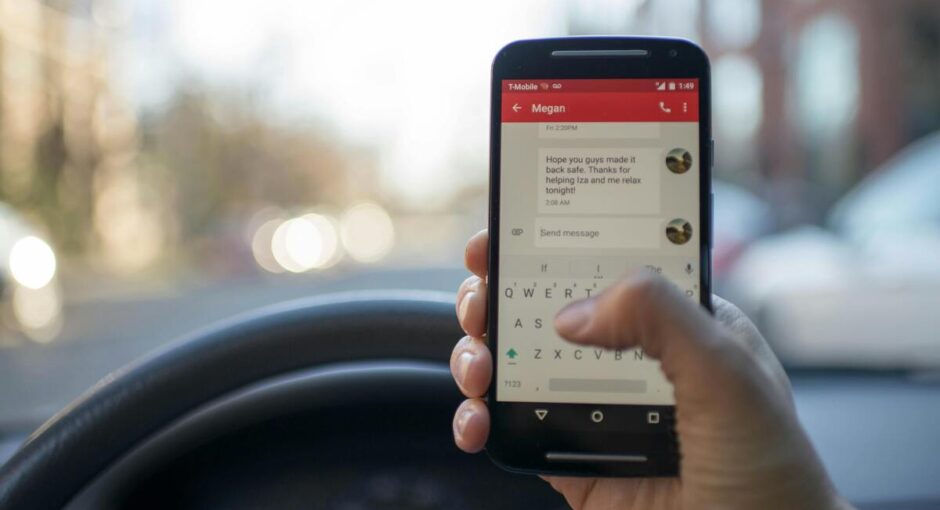

スマートフォンの普及により、位置情報を活用した検索機能の重要性が高まっています。

ジオサーチの最適化

現在地周辺の店舗検索を効率的に処理するため、地理空間インデックスの活用が不可欠です。緯度経度情報を用いた距離計算の最適化や、エリアごとのキャッシュ戦略の実装により、高速なジオサーチを実現することができます。

ルート検索との連携

公共交通機関や徒歩でのアクセス時間を考慮した検索機能の実装により、ユーザーの利便性を向上させることができます。外部の地図サービスとのAPIの連携や、経路探索アルゴリズムの実装が必要となります。

インデックス設計

大量のデータから高速に検索結果を返すため、効率的なインデックス設計が重要です。

複合インデックスの最適化

頻繁に使用される検索条件の組み合わせを分析し、適切な複合インデックスを設計することで、検索のパフォーマンスを向上させることができます。インデックスのサイズとメンテナンスコストを考慮しながら、最適なバランスを取ることが重要です。

パーティショニング戦略

データ量の増加に伴うパフォーマンスの低下を防ぐため、適切なパーティショニング戦略の実装が必要です。地域やカテゴリーごとのパーティショニングにより、検索対象の範囲を効率的に絞り込むことができます。

キャッシュ最適化

検索結果のレスポンス時間を改善するため、効果的なキャッシュ戦略の実装が重要です。

検索結果キャッシュ

頻繁に実行される検索パターンの結果をキャッシュすることで、データベースへの負荷を軽減し、応答時間を短縮することができます。キャッシュの有効期限や更新戦略を適切に設定することで、データの鮮度とパフォーマンスのバランスを取ることが重要です。

サジェスト機能の最適化

入力補完や検索候補の表示により、ユーザーの検索体験を向上させることができます。検索履歴やトレンド情報を活用した動的なサジェスト機能の実装が効果的です。

パフォーマンスチューニング

システム全体の応答性を維持するため、継続的なパフォーマンス改善が必要です。

クエリ最適化

実行計画の分析や、クエリパターンの監視により、ボトルネックとなっている検索処理を特定し、最適化を行うことができます。特に、結合を含む複雑なクエリについては、慎重な最適化が必要です。

負荷分散設計

検索トラフィックの増加に対応するため、適切な負荷分散設計が重要です。レプリケーションの活用や、読み取り専用スレーブの配置により、システム全体の安定性を確保することができます。

レコメンド機能の開発

グルメサイトにおいて、ユーザーの好みや行動パターンに基づいた適切な店舗推薦は、顧客満足度とエンゲージメントの向上に直結します。

本セクションでは、効果的なレコメンドシステムの設計から実装まで、具体的な手法について解説します。

パーソナライズ推薦エンジン

個々のユーザーの嗜好や行動履歴に基づいて、最適な店舗を推薦するシステムの構築が重要です。

行動履歴分析

ユーザーの閲覧履歴、予約履歴、レビュー投稿などの行動データを総合的に分析することで、個々の好みを理解し、より精度の高い推薦が可能となります。特に、直近の行動により重み付けを行うことで、現在のニーズにより適した推薦を実現することができます。

協調フィルタリング

類似したユーザーの行動パターンを分析することで、まだ訪れていない店舗の中から、興味を持つ可能性が高い店舗を推薦することができます。ユーザー間の類似度計算には、レビュー評価の傾向や、好みのジャンル、価格帯などの要素を考慮することが効果的です。

コンテキスト分析

利用シーンや環境要因を考慮した、より適切な推薦を実現するためのシステム構築について説明します。

時間帯別最適化

ランチタイムやディナータイムなど、時間帯に応じて異なる推薦ロジックを適用することで、より状況に適した店舗を提案することができます。また、平日と週末で異なる傾向を示すユーザーの行動パターンにも対応することが重要です。

位置情報活用

ユーザーの現在地や普段の行動範囲を考慮した推薦により、実際に訪問しやすい店舗を優先的に表示することができます。通勤経路上の店舗や、最寄り駅周辺の店舗など、利便性を考慮した推薦が効果的です。

嗜好学習モデル

ユーザーの嗜好をより深く理解し、推薦精度を向上させるための機械学習モデルの実装について解説します。

特徴量エンジニアリング

店舗の属性データ、メニュー情報、雰囲気、価格帯など、多様な特徴量を組み合わせることで、ユーザーの好みをより正確にモデル化することができます。また、季節性や特別な催事なども考慮に入れることで、より適切な推薦が可能となります。

モデル最適化

定期的な精度評価と改善を行うことで、推薦システムの品質を維持・向上させることが重要です。クリック率や実際の来店率などの指標を活用し、モデルの調整を行うことで、より効果的な推薦を実現することができます。

トレンド分析

最新の人気店や話題のメニューを適切にレコメンドに反映させるシステムを構築します。

リアルタイムトレンド

SNSでの話題度や予約状況、レビュー投稿数など、リアルタイムなデータを分析することで、現在注目を集めている店舗を適切に推薦することができます。特に、新規オープン店舗や期間限定メニューについては、優先的な露出を検討することが効果的です。

季節性考慮

季節やイベントに応じて変化する食の嗜好を考慮し、その時期に適した店舗やメニューを推薦することが重要です。花見シーズンの屋外席や、暑い時期の冷たい麺類など、季節に応じた需要の変化に対応することができます。

パフォーマンス最適化

大規模なデータ処理と迅速なレスポンスを両立させるための技術的な最適化について解説します。

キャッシュ戦略

頻繁に計算される推薦結果をキャッシュすることで、レスポンス時間を短縮し、システムの負荷を軽減することができます。ユーザーセグメントごとの推薦リストや、トレンド情報など、適切なキャッシュ戦略の設計が重要です。

分散処理設計

大量のユーザーデータと店舗情報を効率的に処理するため、推薦計算の分散処理システムを構築することが必要です。バッチ処理とリアルタイム処理を適切に組み合わせることで、効率的な推薦システムを実現することができます。

システム運用管理

グルメサイトの安定的な運用には、効率的なデプロイメント体制から障害対応まで、包括的な運用管理体制の構築が不可欠です。

本セクションでは、大規模サービスの安定運用を実現するための具体的な方法論について解説します。

デプロイメント管理

継続的な機能改善とサービス品質の維持を両立させるため、効率的なデプロイメントプロセスの確立が重要です。

デプロイメントパイプライン

自動化されたビルドプロセスとテスト実行により、デプロイメントの安全性と効率性を確保することができます。

コードレビューから本番環境へのリリースまで、各段階での品質チェックと承認フローを明確化することで、安定したリリースサイクルを実現することが可能です。

ステージング環境管理

本番環境と同等の構成を持つステージング環境を整備することで、リリース前の十分な動作検証が可能となります。特に、データベースの整合性やキャッシュの挙動など、本番環境特有の課題を事前に検証することが重要です。

モニタリング体制

システムの健全性を継続的に監視し、問題を早期に発見するための体制構築について説明します。

メトリクス監視

CPUやメモリ使用率、レスポンスタイム、エラー率など、重要な指標をリアルタイムで監視することで、システムの状態を常に把握することができます。閾値アラートの設定により、異常の早期発見と対応が可能となります。

ログ分析

アプリケーションログやアクセスログの分析により、システムの挙動や利用傾向を詳細に把握することができます。ログ集約基盤の構築と、効率的な検索・分析手法の確立が重要です。

インシデント対応

システム障害や不具合が発生した際の、迅速かつ適切な対応体制の構築について解説します。

エスカレーションフロー

障害の影響度に応じた適切なエスカレーションルートを確立し、必要な関係者への迅速な情報共有を実現することができます。特に、ユーザーへの影響が大きい障害については、経営層への報告基準も明確にすることが重要です。

障害対応手順

発生した障害に対する初動対応から原因究明、再発防止策の実施まで、一連の対応プロセスを標準化することが重要です。障害報告書のテンプレート化や、過去の障害事例のナレッジベース化も効果的です。

セキュリティ管理

システムのセキュリティを継続的に維持・向上させるための施策について説明します。

脆弱性対策

定期的なセキュリティ診断の実施や、既知の脆弱性情報の収集により、システムの安全性を確保することができます。特に、外部からの攻撃に対する防御策の強化と、内部からの情報漏洩対策の両面が重要です。

アクセス権限管理

システム管理者や運用担当者のアクセス権限を適切に管理し、定期的な棚卸しを行うことで、セキュリティリスクを低減することができます。特権アカウントの使用ログ監視も重要な要素となります。

バックアップ管理

データの保全とシステム復旧のための体制について解説します。

バックアップ戦略

定期的なフルバックアップと差分バックアップの組み合わせにより、効率的なデータ保護を実現することができます。バックアップデータの保管場所や保持期間の設定も重要な検討事項となります。

リストア手順

障害発生時のデータ復旧手順を明確化し、定期的な復旧訓練を実施することで、実際の障害時に迅速な対応が可能となります。特に、大規模なデータ復旧に要する時間の見積もりと、段階的な復旧手順の確立が重要です。

ケーススタディ

実際のグルメサイト開発プロジェクトから得られた知見と成功事例を紹介します。

本セクションでは、開発チームが直面した課題とその解決策、そして実装後の効果について具体的に解説します。

A社の地域特化型グルメサイト開発事例

地方都市における飲食店情報プラットフォームの構築事例から、地域密着型サービスの開発ポイントを解説します。

プロジェクト概要と課題

人口50万人規模の地方都市において、地域特性を活かしたグルメ情報サイトの開発に取り組んだA社の事例です。開発期間6ヶ月、開発者5名、デザイナー2名という比較的小規模なチームで、ローカルコミュニティに根ざしたサービスを実現しました。

実装のポイントと工夫

方言対応の検索機能や、地域特有の食文化に対応したカテゴリー分類など、地域特性を考慮したカスタマイズを実施しました。また、地域のイベント情報との連携機能により、観光客向けの情報発信も強化することができます。

B社の大規模グルメチェーン向けカスタマイズ事例

全国展開する大手飲食チェーン向けの予約・レビューシステム開発事例について解説します。

システム要件と開発体制

100店舗以上を展開する飲食チェーンの予約管理システムとレビュープラットフォームの統合開発に取り組んだ事例です。開発期間12ヶ月、開発チーム15名という大規模プロジェクトとなりました。

機能実装と最適化

店舗ごとの在庫管理やスタッフシフト連携など、チェーン店特有の要件に対応したカスタマイズを実施しました。また、大量の予約データを効率的に処理するための独自のアルゴリズムも開発しています。

C社のグローバル展開事例

多言語対応とクロスボーダー決済システムの実装について、具体的な取り組みを紹介します。

グローバル化への対応

インバウンド観光客向けのサービス展開を目指したC社の事例では、多言語対応のレビューシステムと、国際決済への対応が主要な課題となりました。

技術的な解決策

言語切替機能の実装や、通貨換算システムの開発など、グローバルサービスならではの技術課題に取り組みました。特に、異なる文字体系での検索機能の最適化には多くの工夫が必要でした。

D社のレビュー品質向上プロジェクト

レビューの信頼性向上を目指した施策と、その効果について解説します。

課題分析と対策立案

ステルスマーケティングや悪意あるレビューへの対策として、AI活用による不正検知システムの開発に取り組んだD社の事例を紹介します。

施策の効果と今後の展望

レビュー品質の向上により、サイトの信頼性が大きく向上し、ユーザー数の増加にもつながりました。今後は、機械学習モデルの精度向上に継続的に取り組む予定です。

失敗事例から学ぶ教訓

実際のプロジェクトで発生した問題とその解決策について説明します。

パフォーマンス問題への対応

アクセス集中時のシステムダウンや、検索機能の応答遅延など、実際に発生した問題とその解決方法について詳しく解説します。

ユーザビリティ改善の取り組み

ユーザーテストで明らかになった問題点と、それを解決するためのUI/UX改善施策について具体的に説明します。

まとめと成功のポイント

各事例から得られた知見をもとに、グルメサイト開発における重要な成功要因について解説します。開発規模や地域特性に関わらず、ユーザーニーズの理解と適切な技術選択が成功の鍵となることが明らかになりました。

よくある質問(Q&A)

グルメサイト開発プロジェクトを進める中で、多くの開発者やプロジェクトマネージャーから寄せられる質問について、実践的な回答を提供します。

本セクションでは、技術選定から運用管理まで、幅広いトピックについて解説します。

データベース設計に関する質問

スケーラビリティの確保について

質問:「大規模なデータベースのスケーリングはどのように行うべきですか?」

データベースのスケーリングについては、初期段階からシャーディングを考慮した設計を行うことが重要です。水平スケーリングが可能な構造を採用し、データの分散化を計画的に進めることで、将来的な拡張にも対応できます。

また、読み取り負荷の分散には、レプリケーションの導入が効果的です。

レビューシステムに関する質問

信頼性の担保について

質問:「レビューの信頼性をどのように確保すべきですか?」

レビューの信頼性確保には、多層的なアプローチが必要です。ユーザー認証の強化、投稿ガイドラインの整備、AIを活用した不正検知システムの導入を組み合わせることで、高い信頼性を実現できます。また、モデレーターによる確認プロセスの確立も重要です。

検索機能に関する質問

パフォーマンス最適化について

質問:「検索機能のパフォーマンスを向上させるにはどうすればよいですか?」

検索パフォーマンスの向上には、Elasticsearchなどの専用検索エンジンの導入が効果的です。また、キャッシュ戦略の最適化やインデックス設計の見直しにより、より快適な検索体験を提供することができます。

システム運用に関する質問

障害対策について

質問:「システム障害時の対応をどのように整備すべきですか?」

システム障害への対応は、事前の準備が重要です。障害検知の自動化、エスカレーションフローの整備、復旧手順の文書化を行い、定期的な訓練を実施することで、実際の障害時にも迅速な対応が可能となります。

セキュリティに関する質問

個人情報保護について

質問:「ユーザーの個人情報をどのように保護すべきですか?」

個人情報の保護には、データの暗号化、アクセス権限の厳格な管理、定期的なセキュリティ監査の実施が不可欠です。また、GDPR等の各種規制に準拠したデータ取り扱いポリシーの策定も重要となります。

パフォーマンスに関する質問

負荷対策について

質問:「アクセス集中時の対策はどのように行うべきですか?」

アクセス集中への対策として、オートスケーリングの設定、CDNの活用、キャッシュ戦略の最適化が効果的です。また、定期的な負荷テストを実施し、システムの限界値を把握することも重要です。

開発プロセスに関する質問

品質管理について

質問:「開発における品質管理をどのように行うべきですか?」

品質管理には、自動テストの導入、コードレビューの徹底、CI/CDパイプラインの整備が重要です。また、定期的なコード品質メトリクスの確認と、技術的負債の管理も必要となります。

これらの質問と回答は、実際のプロジェクトで直面する課題に基づいています。開発チームの規模や要件に応じて、適切にカスタマイズしながら活用することをお勧めします。

まとめ

グルメサイト開発において、ユーザー満足度の向上とシステムの安定運用を実現するためには、多岐にわたる要素を適切に設計・実装する必要があります。

本セクションでは、これまでの内容を総括し、成功に導くための重要なポイントをまとめます。

基本設計の重要性

効率的なデータベース設計とスケーラブルなアーキテクチャの構築は、サービスの基盤として極めて重要です。将来の拡張性を考慮した設計により、継続的な機能追加やパフォーマンス改善が可能となります。

ユーザー体験の最適化

高度な検索機能とパーソナライズされたレコメンド機能の実装により、ユーザーが求める情報に素早くアクセスできる環境を整えることが重要です。また、レビューシステムの信頼性確保により、プラットフォーム全体の価値を高めることができます。

運用管理の効率化

システムの安定運用には、効果的なモニタリング体制とインシデント対応プロセスの確立が不可欠です。また、継続的な改善のためのデータ分析と、セキュリティ対策の強化も重要な要素となります。

今後の展望

技術の進化に伴い、AIを活用した機能強化や、よりパーソナライズされたサービス提供が可能となっています。市場のニーズと技術トレンドを見据えながら、継続的な機能改善を進めることが重要です。

本ガイドで解説した内容を参考に、ユーザーにとって価値のある、そして技術的にも優れたグルメプラットフォームの構築を目指していただければ幸いです。

ベトナムオフショア開発のメリット

特に、ベトナムでのオフショア開発は、高品質な開発リソースを効率的に活用できる優れた選択肢となります。Mattockでは、豊富な開発実績と専門知識を活かし、お客様の人事管理システム開発を強力にサポートいたします。

人事管理システムの開発について、より詳しい情報や個別のご相談をご希望の方は、ぜひMattockの問い合わせフォームよりご連絡ください。経験豊富なコンサルタントが、貴社の要件に合わせた最適なソリューションをご提案させていただきます。

▼詳しい情報・ご相談はこちら